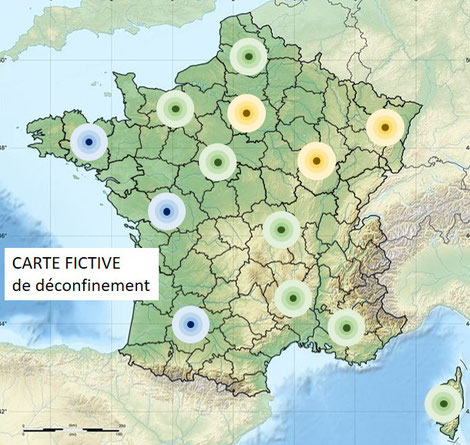

Inondations Pas-de-Calais - Enseignements peuvent tirer de cette catastrophe naturelle ? Adaptation territoriale et solutions

🌊👔 Pour sa 1ère visite comme Premier ministre, Gabriel Attal a visité le Pas-de-Calais à la suite des #inondations. Quels enseignements l'État, les collectivités, les particuliers et les entreprises peuvent tirer de cette catastrophe naturelle ?

🌀 “Perfect Storm” - Le Pas-de-Calais a été confronté à une combinaison de facteurs qui se répéteront dans le futur

➡️ de très fortes précipitations s'accentuant avec le #réchauffementclimatique car +1°C = +7% teneur en vapeur d'eau max de l'atmosphère qui se transforme en pluie torrentielle quand les masses d'air chaud humides rencontrent des masses d'air froid

➡️ un territoire très plat (max 212 m d'altitude)

➡️ des sols déjà gorgés d'eau et des nappes phréatiques pleines et peu profondes (réactives)

➡️ des marées poussant l’eau vers l’intérieur des côtes

❄ Le gel récent puis son dégel fragiliseront aussi des logements et des infrastructures (principe similaire aux éboulements dans les montagnes)

🏞️ Solutions à long terme pour réduire les risques d'inondation et leurs impacts :

➡️ laisser de larges espaces pour que le trop-plein d'eau des crues puisse s'y déverser (stratégie "room for river" des Pays-Bas) ce qui signifie empêcher la construction d'habitations voire déplacer des habitants. Ces espaces peuvent être des espaces verts, utilisables hors des périodes d'inondation

➡️ désimperméabiliser les sols (ne pas artificialiser et même débétonner : places, cours d'école, parties de trottoir...), éviter le labour qui compacte les sols et donc le rend plus imperméable, planter des haies bocagères (qui accroît la perméabilité des sols et réduit le ruissellement des eaux) avec la participation des agriculteurs

➡️ Le curage des digues des Wateringues aurait sans doute atténué l'impact de ces inondations sans pour autant les empêcher

🏘️ Solutions pour les habitants:

➡️ Pour celles et ceux qui veulent absolument rester et si c'est possible, aménager (ex: rdc) afin que les dégâts d'inondations restent minimes

➡️ Pour celles et ceux qui décident de partir : le rachat des logements par l'Etat (financé avec le fonds Barnier) mais avec des décotes importantes. Quid du relogement ?

🔭 Afin d'anticiper

➡️ Le site georisques.gouv.fr permet d’identifier précisément les risques naturels et industriels à son adresse précise

➡️ Les assurances pourraient informer beaucoup plus clairement les habitants des risques futurs (par ex sur leur avis d'échéance, par mail...) en proposant aussi des solutions pour anticiper le risque

➡️ Réaliser des exercices grandeur nature (par temps de pluie ;)) pour anticiper les inondations et sensibiliser chacun sur ses implications

🤝 L’État et les régions jouent un rôle crucial pour impulser, structurer, mutualiser les initiatives et faciliter la coopération entre acteurs, l’accès aux ressources financières et humaines afin d’éviter ce sentiment terrible d’abandon et d'inaction.

➡️ Interview par Céline Pitelet sur BFMTV avec Marc Lomazzi

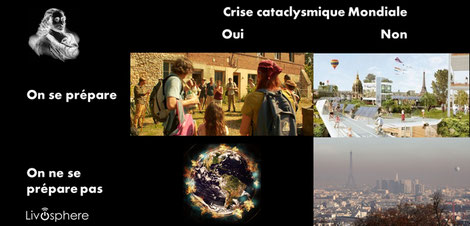

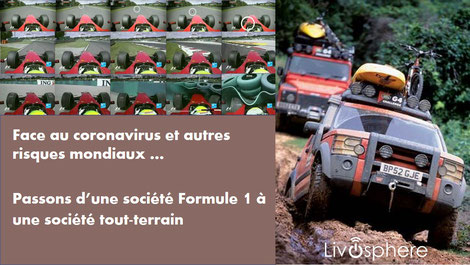

Bonne Année 2024 - Construire des résiliences territoriales

🥳 Bonne Année 2024… 😜 Est-ce une si bonne idée de se souhaiter bonne année malgré les guerres en Ukraine, Israël-Hamas, le manque d’actions face au #dérèglementclimatique, la chute de la #biodiversité, la multiplication des sécheresses, inondations, sans parler du risque de récession et des potentiels résultats des élections européennes et américaines…

🍾 OUI ! Au-delà de mon éternel réalisme optimiste (qui a un petit goût de méthode Coué, mais avec des vertus auto-réalisatrices, si, si…), souhaitons-nous BONNE ANNÉE !

🤔 Mais, à une petite condition…

🛠️ Nous ne résoudrons pas tous les problèmes du Monde, toutefois, nous pouvons changer la donne au moins sur notre entourage et notre environnement de manière constructive.

❓ Comment ?

🌍 ➤ 🏘️ Prenons l’exemple de notre chère Planète, mais à une échelle plus locale (plus facile !). On peut se poser plusieurs questions :

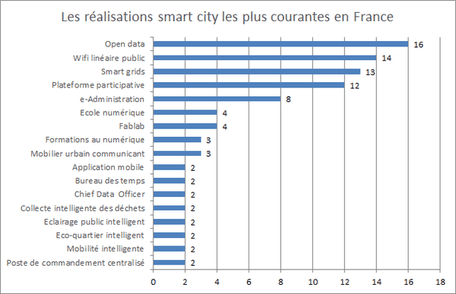

1️⃣ Niveau 1 : Qu’est-ce que je peux faire dans mon quartier, ma ville pour qu’elle soit plus verte, facilite nos déplacements peu carbonés, nous fasse profiter de produits plus locaux, dépenser moins en gaz, fioul, électricité sans en souffrir au quotidien

2️⃣ Niveau 2 : Quelles initiatives existent déjà autour de moi, dans ma ville, entreprise, associations… qui contribuent à cela ? En quoi je peux donner un coup de main qui, by the way, aurait aussi un impact sur moi et mon entourage ?

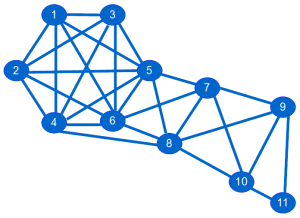

3️⃣ Niveau 3 : Des initiatives, il y en a partout. Alors, comment aider à mutualiser les ressources, idées, outils avec d’autres collectivités, entreprises pour faciliter leur mise en oeuvre, réduire le gaspillage en temps et argent ? Y a-t-il des initiatives ailleurs qui peuvent nous inspirer ? Est-ce que nous pouvons diffuser / partager nos initiatives ailleurs pour aider d’autres ?

4️⃣ Niveau 4 (Etat, Régions, Entreprises) : Comment faciliter l’usage de la multitude de plateformes publiques et privées recensant plein d’initiatives locales (ex: Optigede, Solutions d’élus, Territoires en Commun…) ?

Voici une démarche possible :

- L’Etat (cc #SGPE) pourrait proposer une structuration normalisée des données de partage d’initiatives (ex: Champ 1 - Nom de l’initiative, Champ 2 : Code INSEE des territoires concernés, Champ 3 : Description, Champ 4 : Contact …. Champs N : champs personnalisés)

- Donner accès en #OpenData à l’ensemble des fiches via des API afin qu’on puisse créer une plateforme simple pour accéder à toutes les infos (publique ou privée comme CovidTracker)

- Faciliter l’utilisation avec des outils type ChatGPT (cf. Mirakl, LaReserve.tech, Data for Good) pour qu’une collectivité trouve facilement les fiches les plus pertinentes selon sa problématique.

🔭 2024 et les années suivantes vont être compliquées … En s’appropriant nos propres enjeux localement, en allant un cran plus loin et en démultipliant l’impact de nos initiatives avec le soutien de l’Etat et des régions (cf. la société « boule de gui » ;)), on aura toujours de bonnes raisons de se souhaiter Bonne Année 2025 ! 🥳

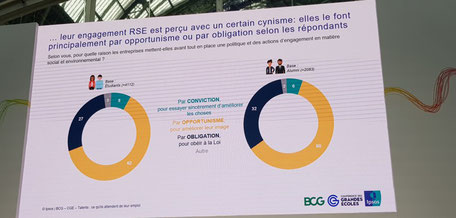

Babilou, parcours d’une entreprise à mission et mon rôle dans son comité de mission

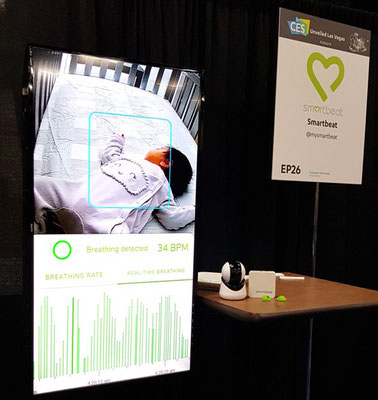

👶 🧭 En novembre 2023, j'embarquai dans l’aventure d’une entreprise à mission avec Babilou Family au sein de son Comité de mission.

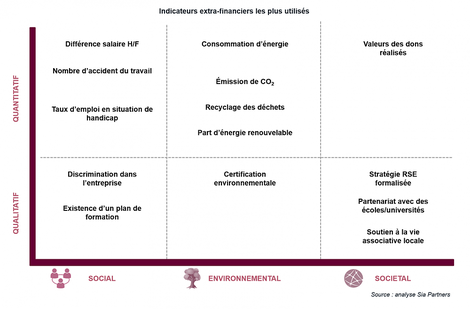

🌍Début 2022, j’ai accompagné Babilou (gère des crèches d'entreprises et de collectivités) dans la construction de leur stratégie RSE (construction de la matrice de matérialité pour comprendre l’importance des différents ODD / SDG pour chaque pays et ses parties prenantes, les freins et moyens d’action plus l’élaboration d’indicateurs ESG).

🕴️ C’était aussi l’occasion de voir à quel point sa raison d’être (“Construire un monde meilleur par l'éducation et l'attention portée à chaque enfant”) était incarnée par son président Xavier Ouvrard, son comité de direction et l’ensemble des collaborateurs de Babilou :)

🧍🧍♀️🧍🏿♀️🧍♀️Fin 2022, Babilou devenait une entreprise à mission. Xavier Ouvrard, Sridevi Raghavan et Vanessa Zerbib me proposaient de faire partie du Comité de Mission avec Emmanuelle Lievremont (L'Oréal), Kévin André (kawaa) autour de 4 piliers (people, planet, pedagogy, positive growth), ce qui m’a beaucoup touché.

🗺️ Fin novembre 2023, nous nous sommes réunis entre membres et avec le COMEX de Babilou, avons réalisé une Fresque de la Mission, partagé les objectifs et rencontré Sarah GUEREAU (Organisme Tiers Independant - OTI)

🤝 Nous avons trouvé une vraie complémentarité entre les membres du comité. Déjà engagé sur les enjeux “sustainability” (implication Les Shifters, missions RSE, Livre 2050, Crash ou Renaissance ? Vers une société « boule de gui », je souhaite m’impliquer aussi sur les autres sujets.

🔢 Nous avons déjà commencé à traduire les engagements en indicateurs (KPI) afin de pouvoir les suivre et les transformer en actions.

🔎 Ces indicateurs servent à l’OTI afin de s’assurer que les engagements sont bien respectés. Cela peut sembler facile, car c’est l’entreprise qui les fixe. C’est sans compter la volonté de Babilou d’être ambitieux sur chaque axe. En outre, s’engager à être une entreprise à mission, juste pour faire du greenwashing est beaucoup de paperasse pour du flanc ! A l’inverse, il y a une complémentarité entre la mission (qui est le cap et la direction de l’entreprise ) et les obligations de la CSRD (tableau de bord).

🌎 🌍 🌏 L’exercice est loin d’être anodin pour Babilou sachant qu’elle est implantée dans une douzaine de pays avec des cultures très différentes : France, Etats-Unis, Singapour, Inde, Colombie… avec des modèles différents, certains subventionnés (comme en France) d’autres non (comme aux Etats-Unis). Comme les enfants ont entre 0 et 3 ans, il y a une plus grande liberté dans les apprentissages. On peut introduire plus facilement des méthodes comme Montessori (pour l’anecdote, quand j’ai vécu à Londres de 5 à 8 ans, mes deux 1ères années en école primaire anglaise étaient à l’école Montessori ;) )

🎨 Et malgré cette diversité, la mission s’applique à toutes les filiales de Babilou Family.

📖 C’est un joli chapitre qui s’ouvre avec Babilou et je suis heureux d’en faire partie :)

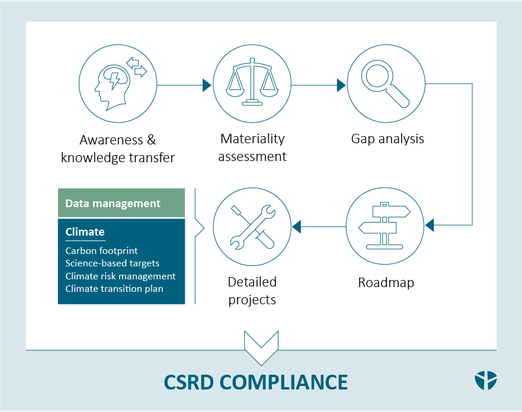

CSRD, la démarche pour la mettre en place

🤔🌎1178, ce chiffre ne vous dit rien, je ne parle ni de l’article 1178 du code civil frappant de nullité les contrats, ni de l’année où le roi Sverre de Norvège, fut victorieux sur le lac gelé de Storsjön, non, c’est le nombre de datapoints ESRS à remplir potentiellement pour digitaliser son reporting CSRD et établis par l’EFRAG

😛Vous l’aviez sur le bout de la langue ? ;)

🧠 Pour les habitants de la Béotie, sachez que nul ne vous en voudra si ce chiffre fait un aller-retour dans votre cortex préfrontal.

😱En revanche, il pourrait hanter les nuits des DAF et des responsables RSE, se voyant grimper une pyramide de 1178 marches, avec un sac à dos plein de lourdeurs administratives.

💡Pourtant, il y a une lueur d’espoir !

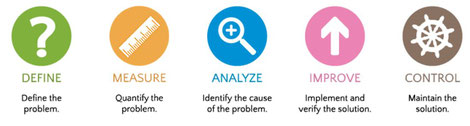

🔢Il faut s’y prendre tôt et savoir qu’il existe des raccourcis. En effet, si le reporting CSRD contient 1178 datapoints sur les sujets ESG (Environnement, Social et Gouvernance), vous n’êtes pas obligés de tous les remplir… si vous avez un peu de méthode.

📊La 1ère étape est de réaliser une analyse de double matérialité.

(cf. post : http://tiny.cc/pst_csrd_3010 )

🔍Kesako ? identifier les informations (ESRS pour les initiés ;) ) devant être divulguées (dites matérielles) et qualifiant ou quantifiant les impacts ESG sur l’entreprise (ex: climat) ou les impacts de l’entreprise sur les sujets ESG (ex: pollution, climat)

📉Cela permet de réduire significativement le nombre de données (au moins 50%) à collecter…

📊La 1ère étape est de réaliser une analyse de double matérialité.

(cf. post : http://tiny.cc/pst_csrd_3010 )

🔍Kesako ? identifier les informations (ESRS pour les initiés ;) ) devant être divulguées (dites matérielles) et qualifiant ou quantifiant les impacts ESG sur l’entreprise (ex: climat) ou les impacts de l’entreprise sur les sujets ESG (ex: pollution, climat)

📉Cela permet de réduire significativement le nombre de données (au moins 50%) à collecter…

🤞D’où la 2ème étape, le Gap analysis consistant à identifier les mesures que l’on a déjà totalement (lucky), partiellement (less lucky), pas du tout (not lucky!). Cela ressemble aux 12 travaux d’Hercule et en général, on commence par nettoyer les écuries d’Augias !

🚣Pour collecter les données, les agréger, les traiter puis les mettre en forme au format xHTML - ESEF (je passe les détails…), il y a un peu de boulot d’autant que 2/3 des données sont qualitatives (donc des entretiens, des questionnaires…) et 1/3 quantitatives (donc des moyens de les collecter, de vérifier leur fiabilité.)

🧗Et évidemment, il ne suffit pas de mesurer, il faut aussi s’améliorer avec un plan d’action.

🏭Cela ressemble à une usine à gaz, c’est clair que les premières années ça va être rude (l’IA générative peut devenir très utile pour gérer cette complexité, trouver les sources d’informations, synthétiser… même si elle est nettement insuffisante pour faire tout le job et qu’elle n’est guère exempt de reproches en termes environnementaux),

🔮Pourtant, la CSRD a un réel intérêt, c’est un bon moyen de mettre en avant les entreprises mieux-disantes sur le plan environnemental et social, mais aussi que de réduire fortement la taille des placards pour les potentiels cadavres environnementaux et sociaux.

🎤 Si vous souhaitez réaliser une conférence, sensibilisation ou plus si affinités ! sur le sujet, n'hésitez pas à me contacter via MP.

Si vous avez un projet de mise en place de la CSRD ou vous souhaitez une sensibilisation / formation auprès de vos équipes à ce sujet, n'hésitez pas à me contacter ici.

Marne, intervention sur la stratégie d'atténuation et d'adaptation au changement climatique pour les territoires

🥁 🌍 La Marne mène sa transition environnementale, tambour battant ! Après un discours volontariste et pragmatique sur les enjeux climatiques et environnementaux de Franck Leroy, président de la Région Grand Est, je suis intervenu sur la stratégie de résilience des territoires comme Les Shifters / The Shift Project. Anne Clerc (SGPE) intervenait pour présenter les COP territoriales et le préfet Henri Prévost clôturait ce 71ème congrès de l'association des Maires de la Marne, organisé avec talent par Karine Rolland.

🌍 🔭 🛠️ Franck Leroy a donné une vision claire et concrète des enjeux, les efforts futurs à réaliser et le chemin déjà parcouru. Il s'appuie aussi sur l'association des maires qui aide et forme les élus sur ce sujet (ex sur l'eau). Fortement aligné avec la ligne directrice du Shift Project et des Shifters, il tord aussi le cou à cette idée reçue qu'avoir une politique environnementale n'est l'apanage que de partis de gauche ou écologiste ;)

🎤 / 🧗♀️ Intervenir devant cette assemblée était un challenge ;) En effet, beaucoup de maires avaient parfaitement conscience des problématiques de résilience que je présentais, en termes de mobilité, alimentation, logement... et agissaient déjà. Du haut de mon estrade, il m'était facile de dire qu’il serait bien de faire ceci ou cela pour réduire son impact environnemental alors que je n'avais pas les pieds dans la glaise et les mains dans le cambouis.

🤝 Alors, comment faire pour être utile ? Nous pouvons comme citoyens (via les Shifters, les associations locales, entre voisins...) changer notre rapport avec les maires et élus. Plutôt que d'être en position de demander, nous pouvons être en situation de proposer. Les maires et élus peuvent aussi rebondir sur des demandes de leurs concitoyens en leur proposant de collaborer ensemble pour identifier des solutions avec leur soutien. Vu que ce sera plus compliqué demain qu'aujourd'hui, autant commencer à tisser des liens et s'entraider dès à présent.

🚣 / 🏄 Petite remontée des maires pour les acteurs publics : les appels à projets sont assez fastidieux à remplir en particulier pour les petites communes qui n’ont pas toujours les ressources suffisantes pour répondre à temps. Pourquoi ne pas créer des appels à projets plus faciles d'accès, plus rapides à réaliser, réservés aux petites communes car cela rééquilibrerait les forces face aux des grandes collectivités. On pourrait aussi favoriser des "coalitions" de petites communes pour y répondre et mutualiser leurs ressources.

🏆 Les COP Territoriales présentées par Anne Clerc peuvent aussi être un moyen de réunir des communes mais aussi d'autres acteurs : entreprises, agriculteurs, habitants ... autour de projets communs qui peuvent à la fois réduire les émissions carbone, accroître leur résilience mais aussi (et surtout) apporter des co-bénéfices comme une réduction des coûts, une meilleure qualité de vie, une meilleure santé, un accès plus facile à certains services...

Si vous êtes intéressé par une intervention sur la stratégie d'atténuation ou d'adaptation au changement climatique pour un territoire ou une entreprise, n'hésitez pas à me contacter ici.

CSRD - Non ce n'est pas l’acronyme de C’est Super Rébarbatif et Douloureux

La CSRD, non ce n’est pas l’acronyme de C’est Super Rébarbatif et Douloureux mais un reporting environnemental et social européen qui peut donner des boutons et sueurs froides !

The question is : faut-il le traiter comme ces examens pénibles qu’on révise entre minuit et 6h du mat, juste avant le gong de départ ou qu'on anticipe un peu ? (Levée des copies 1/2025, début de l’examen dans 1 mois)

🈯 Se lancer dans la Corporate Sustainability Reporting Directive, est comme apprendre le javanais quand on ne connaît que quelques mots de français ! De toutes les manières, il va falloir y passer... donc autant s'y préparer.

📝 L’esprit de la CSRD est d’inciter les entreprises à basculer vers un modèle plus durable sur le plan environnemental et social. Comme tout le monde a traîné la patte, le professeur UE a dit “Ca suffit mes gaillards et gaillardes ! Va falloir que vous vous bougiez les miches, examen dans un mois et je vous jure, ça va être carabiné.”

😱 Ca n’a pas raté ! Tout le monde a poussé des cris d’orfraie mais pas le choix, je vous dis. Les bons élèves avaient préparé leur coup, ils se sont dits tant qu’à faire, je bosse mes enjeux environnementaux et sociaux bien en amont, ce sera plus facile de passer l’exam par la suite et au moins ça servira à quelque chose.

🔁 Après, il y a une petite subtilité dans la CSRD, la double matérialité.

👊 / 🤕 Kesako ? Analyser la double matérialité, c’est un peu comme si vous étiez pris dans une bagarre et que vous pesiez le pour et le contre avant d’envoyer un pain, selon la torgnole que vous risquez de prendre en retour.

⇋ ⇌ Pour être plus prosaïque, vous évaluez non seulement ce que l’entreprise a comme impacts environnementaux et sociaux (“Inside-Out” dite matérialité d’impact), mais aussi l’inverse, quels risques font peser les enjeux environnementaux et sociaux sur l’ entreprise ("Outside-in" dite matérialité financière).

😇 / 👺 Emmanuel Faber, notre bon samaritain des "large corporations" (à la tête de l' ISSB donnant des directives comptables internationales), aurait-il sombré du mauvais côté de la force ? En effet, il est contre la double matérialité et préconise donc de ne prendre en compte que les risques qu’encoure l’entreprise. (cf. http://tiny.cc/efab_dbm )

🤪 C’est un peu comme si une société prélevant beaucoup d’eau dans des nappes phréatiques ferait part de son risque d’être victime de pénuries d’eau en oubliant qu’elle en est aussi responsable… 😜

↢↣ C’est pas tout, il faut se mettre au boulot là, d’abord réaliser un “gap analysis” entre les données déjà collectées et celles à récupérer pour la CSRD, puis travailler dans la mine … pour collecter de nouvelles données, les agréger, les traiter et les mettre dans les bonnes cases !

🏭 Tant qu’à faire, vaut mieux que les données récupérées pour la CSRD servent aussi à l’activité. L’usine à gaz dans un monde décarboné n’est pas la meilleure option !

✉️ Je réalise des sensibilisations et mène des projets CSRD (formé à ce sujet) ainsi que des bilans carbone (certifié IFC). Vous pouvez me contacter ici pour en savoir plus.

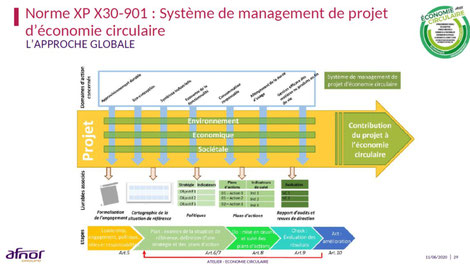

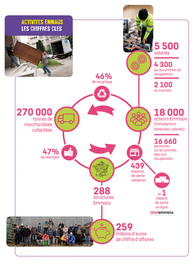

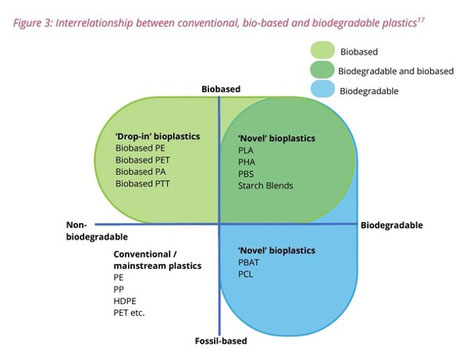

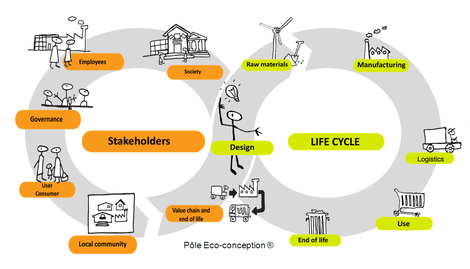

Économie circulaire,ami ou ennemi de la décarbonation ?

♻️ / ↘️🛢️Économie circulaire, ami ou ennemi de la décarbonation ? Hier, j'ai participé à un événement sur l'économiecirculaire de l'Institut Choiseul, l'occasion d'en parler alors qu'un post de Jean-Marc Jancovici commentait la veille un article : Recyclage : Sortir de l'enfumage : https://cutt.ly/jmj_recyc . La matinée était animé par Pierre-Emmanuel Saint-Esprit.

♻️ ⁉️ Qu'en est-il ? Effectivement, la promesse de recyclage est souvent la feuille de vigne qui cache des taux de recyclage réels très faibles à quelques exceptions près (ex: aluminium, PET). Recycler des smartphones juste pour décarboner l'extraction de nanogrammes de terres rares est un non-sens sachant que les concentrations sont inférieures à celles déjà très faibles retrouvées naturellement (vidéo : https://cutt.ly/smartp_terr )

Toutefois, c'est une vision partielle du sujet

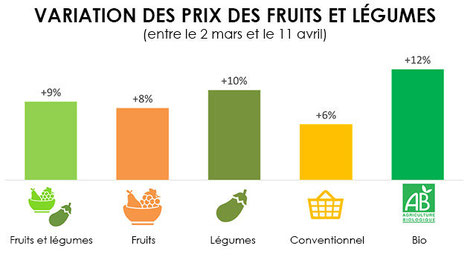

📊 Grâce à un bilan carbone intégrant le Scope 3, on remarque de fortes différences selon le système de collecte, traitement, transport et l'énergie nécessaire pour transformer un déchet en ressources

🐟 Il n'y a pas que le carbone dans la vie. D'autres impacts (ex: dus aux déchets miniers comme pollution, ↘️ biodiversité...) montrent que le recyclage est préférable à la fabrication linéaire (via des analyses de cycle de vie comparatives)

↘️🛑 Le recyclage atténue les pénuries de matières premières et hausses de leur coût, fort levier pour s'y lancer.

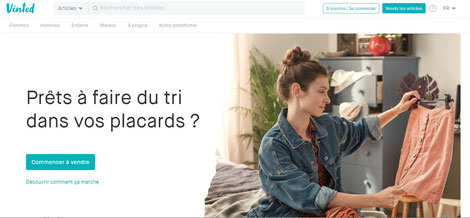

5️⃣R Last but not least, le recyclage est la dernière opération à réaliser après 3 autres des 5R, Refuser, Réduire et Réemployer. Les 2 derniers étant Recycler et Remettre en terre (pour les produits à usage unique compostables à l'air libre). Les 3 1ers principes sont bien plus bénéfiques que la fabrication linéaire et le recyclage. (cf. extrait livre 2050 Crash ou Renaissance ? https://bit.ly/2050_5R)

🎢 Le souci est que c'est compliqué pour une entreprise de passer d'un modèle linéaire à un modèle circulaire car il faut gérer la boucle retour avec des produits hétérogènes, non standardisés parfois obsolètes avec une faible traçabilité dans un processus de fabrication et commercialisation qui exigent des intrants et extrants standardisés.

⌚ Il y a des changements de culture massifs comme passer de la vente de boîtes (puis on oublie) à la vente de services (avec les problèmes de retours clients, de facturation...). Tout cela prend du temps car tous les processus de l'entreprise sont concernés.

⚗️ Il existe des solutions, la première est d'essuyer les plâtres, expérimenter sur des petits périmètres (géographiques, produits secondaires, pièces détachées...), la 2ème est de tester en externalisant sur un périmètre restreint les processus auprès d'entreprises (ex: startups) vendant ce type de solutions en marque blanche et de réinternaliser les briques pertinentes dans un second temps.

🔮 Au final, il faut avoir une vision complète et diverse pour ne pas réduire l'économie circulaire au recyclage et les impacts environnementaux aux émissions GES ;)

N'hésitez pas à me contacter ici si vous souhaitez une intervention (conférence, projet) sur les enejux de l'économie circulaire et comment cela peut se traduire dans votre entreprise.

Comment faire face aux incendies, canicules, au dérèglement climatique ?

🎤 🔥 🥵 Incendies, canicules, dérèglement climatique L'été 2023 a été particulièrement dévastateur… Que dire de plus... quelques idées ;)

🪃 Le Canada, la Chine et les Etats-Unis subissent un effet boomerang, ils pâtissent fortement des effets du dérèglement climatique et y contribue aussi massivement mais les populations font peu le lien entre les 2. Il y a aussi un cercle vicieux entre incendies et réchauffement climatique.

🌋 Ses effets sont exponentiels à l’image de l’échelle Richter pour un tremblement de terre. Passer de 1,5°C à 2°C est comme passer de 6 à 7 (magnitude du séisme au Maroc). Il y a des effets de seuils que nous dépassons. Les petits incendies se transforment en méga-feux.

📝 Le rapport Paris à 50°C initié et coordonné par Alexandre Florentin est un excellent outil pour toutes les communes afin d’identifier les vulnérabilités sur leur territoire et trouver des solutions pour s’y adapter. (lien : http://tiny.cc/paris_50 )

🏚️➤🏘️ Les pouvoirs publics négligent souvent le temps de la reconstruction après le temps de l’urgence et des flashs médias, il faut que l’Etat et les régions facilitent une stratégie de résilience des territoires et que les territoires développent leur coopération/entraide (cf. société « boule de gui » https://bit.ly/2050_lnk )

🌪️ Sur les effets du dérèglement climatique : https://bit.ly/dc_bfm_0823_dereg

➡️ La ville est plus touchée que ses alentours plus verts (+8°C entre Paris intra-muros et RP).

➡️ De nombreuses activités, touristes et zones pourraient être délaissées par la population car invivables une partie de l'année, avec des problématiques de migrations y compris intra-européennes.

➡️ Les atteintes aux infrastructures (avec des effets cascade sur les territoires) aux logements prennent énormément de ressources financières et de temps pour revenir à la normale (parfois jamais). Il faut prévoir comment loger des milliers de personnes qui perdent leur toit sur le temps long.

🥵 Canicule :

➡️ 31% des Franciliens vivent dans des îlots de chaleur potentiels (Etude Institut Paris Région https://cutt.ly/ipr_cani ). Il faut particulièrement prêter attention aux travailleurs à l’extérieur (ex: indemnités chômage intempéries appliquées aux canicules)

➡️ Les collectivités peuvent cartographier les îlots de chaleur, réduire la densité des villes permet de les diminuer mais il faut aussi éviter l’étalement urbain qui augmente les déplacements et donc les émissions de GES !

➡️ Il y a de nombreuses solutions pour adapter les logements (rénovation thermique d’été, blanc de meudon sur les fenêtres, végétalisation des murs avec du lierre…). La climatisation est une mal-adaptation car elle rejette notamment de l’air chaud toutefois elle peut être la seule solution en particulier pour les personnes fragiles.

➡️ Il en existe aussi pour les villes (débétonniser et végétaliser, toitures peints en blanc …)

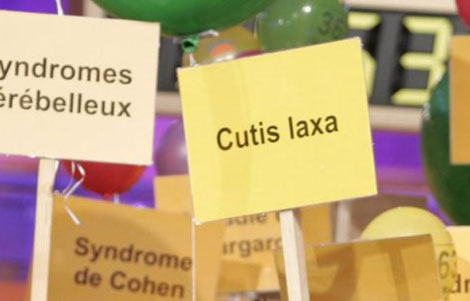

Atelier d'adaptation aux changements climatiques (dont pénuries, hausses de prix, catastrophes naturelles...)

Pénuries, hausses brutales de prix de matières premières, d'énergie, inondations, canicules... touchent de plus en plus d'entreprises et de collectivités. Beaucoup d'entre elles se demandent comment s'adapter à ces conséquences provoquées ou exacerbées par le changement climatique mais ne voient pas trop comment s’y prendre.

L'atelier d'adaptation au changement climatique permet justement à celles-ci d'identifier les principaux risques auxquels elles sont confrontées, de trouver des solutions pour réduire leur exposition et leur vulnérabilité et d'évaluer leur faisabilité ainsi que leurs impacts environnementaux (climat et biodiversité) et sur la justice sociale.

Conçu par Juliette Nouel et Marguerite Deperrois, cet atelier vous permet d'enclencher une démarche de changement au sein de votre entreprise avec la participation de vos équipes internes mais aussi les parties prenantes (fournisseurs , clients, territoires ....) si vous le souhaitez

Déroulé de l'atelier

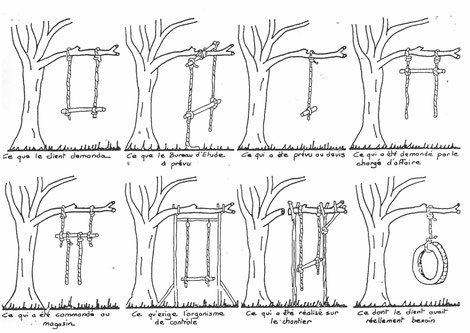

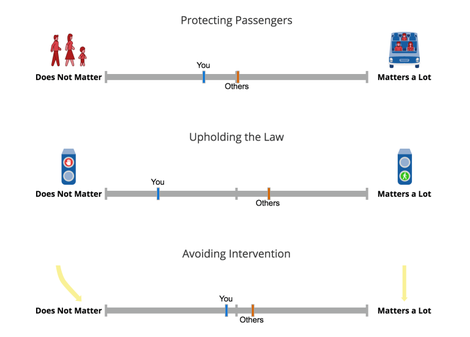

Compréhension sur les moyens de s'adapter à un aléa

1️⃣ La 1ère partie de l'atelier consiste à comprendre ce qu'est l'adaptation :

Si une personne se balade sur un chantier de construction sans casque et qu'une brique lui tombe dessus, on peut décomposer cela en trois éléments :

➡️ L'aléa est la brique qui tombe sur la tête du pauvre mais imprudent garçon

➡️ l'exposition est le lieu où cet incident survient, en l'occurrence le chantier

➡️ la vulnérabilité est le crâne

Il y a deux voies possibles pour éviter cela, la 1ère consiste à réduire l'aléa (équivaut à l'atténuation sur le plan #climatique). Ce n'est pas le sujet ici car d'autres le font déjà.

La 2ème voie est l'adaptation se divisant en 2 parties, réduire l'exposition (ex: ne pas se balader dans un chantier) et réduire la vulnérabilité (mettre un casque).

Exemples concrets sur l'adaptation

Puis, on prend des exemples concrets ex: une habitation en zone inondable, une personne travaillant en extérieur et on identifie ensemble les expositions et les vulnérabilités, puis les moyens pour réduire ces deux dernières.

On filtre ensuite si

📌 la solution a un impact négatif sur le climat ou la biodiversité,

📌 si elle accroit les inégalités sociales et

📌 si elle est faisable.

2️⃣ Cas d'usage venant de l'entreprise ou de la collectivité

Durant la 2ème partie, on part d'une entreprise/collectivité avec un aléa et on déroule toute la pelote...

🍫 On a choisi dans cette session le chocolatier suisse Ragusa (connu pour ses chocolats aux noisettes ) qui ferait face à l'arrêt de l'approvisionnement en fèves de cacao (risque véritable d'ici 30 ans !)

📝 Nous avons identifié les expositions, vulnérabilités, moyens pour les réduire ...

💡 Nous avons été créatifs et avons choisi de basculer vers des recettes aux caroubes ! Torréfié, il a un goût proche du cacao. Le caroubier est cultivé sur le pourtour méditerranéen, se contente d'un sol pauvre et aride... et en plus, peut faire ombrage !

⚗️ Évidemment, on ne va pas basculer vers la caroube du jour au lendemain, mais on va expérimenter cette voie en réalisant des recettes de desserts contenant de la caroube avec des chefs pâtissiers, les tester auprès de consommateurs, discuter avec des cultivateurs pour déterminer la possibilité de planter des caroubiers en remplacement de cultures inadaptées au réchauffement climatique ...

Conclusion

Tout cela prend beaucoup de temps, c'est pourquoi on s'y prend tôt !

On a identifié aussi des solutions à beaucoup plus court terme mais l'objectif de cet atelier est d'ouvrir les chakras pour trouver et tester de nouvelles voies pour s'adapter.

Si vous êtes intéressé de réaliser cet atelier adapté à votre entreprise ou collectivité, n'hésitez pas à nous contacter sur ce formulaire :)

Livre 2050 Crash ou Renaissance ? par Dimitri Carbonnelle

Si vous souhaitez précommander des livres ou avoir une conférence sur le sujet (y compris avant sa sortie car celui-ci a été écrit), vous pouvez le faire directement sur ce lien ou l'indiquer sur cette page

Résumé :

Imaginez 2050 … Plutôt que de se laisser inonder par des images d'effondrement et de catastrophes en série, pourquoi ne pas imaginer un futur tel que nous le voulons et agir en conséquence.

Vivrons-nous un crash ou une renaissance ? Ce sont les choix d'aujourd'hui qui détermineront le monde de demain.

Dans ce livre, Dimitri Carbonnelle donne des clés pour comprendre nos fragilités sociales, économiques, géopolitiques, les origines et les conséquences du réchauffement climatique, de la chute de la biodiversité et des inégalités sociales. Il explique en quoi les technologies peuvent nous aider à les atténuer mais éclaire aussi sur leurs limites et les illusions qu’elles véhiculent. Ce livre détaille des solutions aux consommateurs et citoyens, entreprises, pouvoirs publics pour réduire notre impact environnemental et améliorer notre impact social. Enfin, il propose des voies pour s’adapter et des pistes pour fonder une société résiliente et renaissante, qu’il nomme « société boule de gui ».

Quatre parties :

- Nos fragilités économiques, sociales écologiques et géopolitiques

- Les technologies, ce qu'elles apportent, leurs limites et leurs risques (Hubris)

- Comment atténuer notre impact ? Solutions et exemples concrets

- Comment s'adapter avec ... la société « boule de gui » ? : Remettre le territoire au milieu du village

Conférences - Atténuer l'impact de son entreprise et s'adapter

Dimitri Carbonnelle peut réaliser déjà une conférence dans votre entreprise en présentant les solutions pour atténuer son impact et adapter son entreprise aux enjeux et bouleversements du dérèglement climatique avec le principe de société « boule de gui ». Il adaptera sa conférence en fonction de votre secteur et votre entreprise.

Il réalise régulièrement des conférences dans les entreprises (notamment du Shift Project sur le climat), à Viva Tech (Zéro Carbone),ChangeNow (Packaging durable)... Il est régulièrement interviewé dans les médias notamment sur B Smart TV (industrie verte, économie circulaire, autonomie énergétique, sobriété numérique )

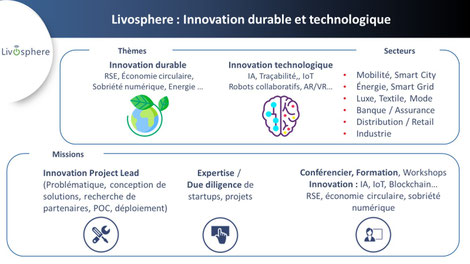

Auteur

Dimitri Carbonnelle, fondateur de Livosphere, société de conseil en développement durable et nouvelles technologies a la passion de créer des ponts entre les innovations d’aujourd’hui et la société de demain. Expert auprès de la BPI, Banque Publique d'investissement dans ces domaines, il est également membre du Shift Project (« think tank » sur la stratégie bas carbone).

Auteur de nombreux articles prospectifs sur ces sujets, il intervient aussi comme conférencier et dans les médias sur des thèmes comme la RSE, l'économie circulaire, la transition écologique, l’usage des technologies.

Stratégie RSE : Sobriété numérique, Numérique, levier environnemental / Digital sustainability Vs Digital for Sustainability

Quelle stratégie adopter pour le numérique dans son entreprise (English version) ? (voir aussi article sur les innovations à ce sujet)

Le numérique est souvent décrié comme un contributeur de plus en plus prépondérant d'émissions de CO2, dégradant l'environnement lorsqu'il faut extraire des métaux rares pour ses batteries, ses processeurs, biberonné à l'obsolescence programmée grâce aux mises à jour « d'OS » qui accélère le renouvellement d'équipement. Pour revenir à plus de sobriété, toute entreprise doit adopter une stratégie pour réduire son impact environnemental lié au numérique.

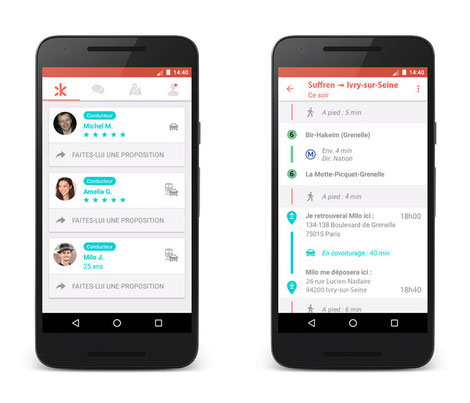

Toutefois, il ne faut pas non plus oublier que le numérique peut devenir un formidable levier pour réduire les émissions de CO2 et son impact environnemental. Mesurer les gaspillages, télétravailler plutôt que prendre son véhicule, réduire les déplacements à ce qui est nécessaire en cas de panne, pour remplir un distributeur automatique ou vider les points de collecte de vêtements , éteindre les lumières et lampadaires lorsqu' il n'y a personne … sont quelques exemples parmi tant d'autres montrant que l'Internet des Objets, l'intelligence artificielle, les plateformes numériques peuvent aussi faciliter la diminution de nos impacts environnementaux de manière globale. Des entreprises comme Phenix ou Too Good to Go ne pourraient distribuer des repas en réduisant le gaspillage alimentaire sans plateforme digitale.

Pour adopter une stratégie cohérente, il marcher sur ces 2 jambes : sobriété numérique ou « digital sustainability « et numérique, levier environnemental ou « digital for sustainability ».

(Pour avoir des sensibilisations, formations même à distance générales ou liées à votre secteur, vous pouvez me contacter ici : contact@livosphere.com ou ici ) Nous menons aussi des projets RSE, sur la sobriété numérique notamment.)

Sommaire (Lien direct vers les parties d'articles - Autre article sur les leviers d'action sur le numérique)

Préambule sur l'impact environnemental du numérique

Stratégie de sobriété numérique

Mesurer

- Mesurer son impact environnemental actuel et se fixer des objectifs, de ses achats, fournisseurs

- Donner des outils à ses collaborateurs pour mesurer leurs impacts

Réduire son impact

- Lié au matériel et équipements numériques, Risque de la location

- Réduire l'impact de ses Data Centers, Co-génération et trigénération pour produire du froid à partir de chaleur

- Point de collecte mixte pro / perso, Software et Stockage, IA, blockchain, objets connectés, 5G

Numérique, levier environnemental

- Partager ses données d’impacts sous forme structurée et en Open source

- Outils pour les salariés (covoiturage, quand acheter un véhicule électrique)

- Pour les clients et fournisseurs, Industrie, Agriculture et autres domaines

Préambule sur l'impact environnemental du numérique

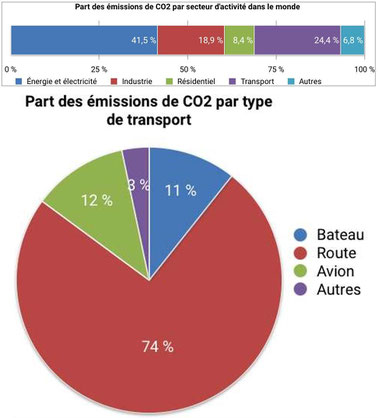

L'impact du numérique serait de 4% des émissions de CO2 en 2020 (3,8% pour GreenIT et 3,7% pour The Shift Project en 2019 !). Il est en forte augmentation, environ 9% par an aujourd'hui (à 2,5% en 2013).

Toutefois, le numérique a bien d'autres impacts, la consommation d'eau (0,2%), l'impact sur les ressources minérales (cobalt, lithium, métaux rares…) et l'environnement (biodiversité, pollution des terres, de l'eau et de l'air, destruction des habitats … en raison des mines qui nécessitent l'extraction de quantités faramineuses de matières pour en extraire de petites quantités de terres rares, les procédés chimiques pour séparer les terres rares des autres éléments notamment l'acide chlorydrique) .

Enfin, l'impact du numérique est à répartir entre la fabrication des équipements (TV, smartphone, ordinateurs), leur usage et la consommation électrique des équipements, ainsi que la fabrication et la consommation énergétique du réseau télécom, des data centers.

Pour réduire son empreinte environnementale numérique, la première mesure consiste à allonger la durée de vie de ses matériels puis de réduire l'usage de ses data centers. La partie réseau est principalement du ressort des opérateurs télécoms. Pour une analyse plus détaillée sur l'impact de la 5G, suivez ce lien.

Stratégie de sobriété numérique

Afin d'avoir toutes les chances de réussir, la sobriété numérique doit s'intégrer dans une stratégie globale RSE soutenue par la direction au risque sinon de perdre la plupart des arbitrages entre sobriété numérique et maintien des habitudes.

A l'image d'un entraînement sportif destiné à faire perdre du poids et prendre de la musculature, il est essentiel aussi de travailler en partenariat avec les salariés, les autres entités du groupe en dehors du SI ainsi qu'avec les fournisseurs, clients …

Mesurer son impact actuel et se fixer des objectifs

Le point de départ est de mesurer son impact actuel. Cela signifie être capable de connaître précisément l'ensemble de son parc informatique, télécoms, imprimantes, TV…

Pour chaque équipement, on peut associer un impact à la fabrication et à l'usage. Il n'est pas nécessaire d'avoir l'impact exact pour chaque équipement qui est souvent quasi impossible à déterminer. Pour commencer, un impact moyen par type d'équipement est nettement suffisant car ce qui était essentiel n'est pas tant la valeur absolue mais la réduction de votre impact .

Pour calculer les émissions liées l'usage, vous pouvez partir des consommations des données constructeurs multipliées par une durée d'utilisation par jour et réaliser un contrôle de cohérence avec les données transmises par votre GTB si elle vous le permet. Il est préférable d'avoir un compteur spécifique pour vos data centers.

Il serait aussi absurde de mettre des systèmes de mesures connectés partout dans votre bâtiment si le gain attendu en augmentant la fiabilité est proche ou plus faible que l'impact négatif dû à la fabrication et l'utilisation de ces objets.

Ensuite, vous pouvez vous fixer un objectif de réduction. Il est préférable de fixer cet objectif en concertation avec la direction RSE afin qu'elle soit cohérente avec la stratégie globale de l'entreprise en matière de RSE.

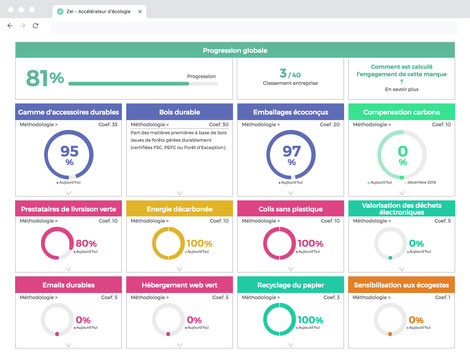

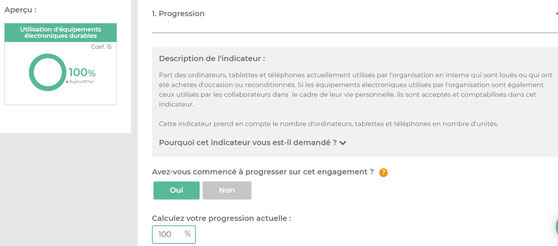

Des outils comme Zei permettent de suivre ses objectifs en se limitant pas à la mesure de la sobriété numérique mais englobant la totalité de la stratégie RSE.

Pour compléter cette mesure, il est aussi utile de mesurer le coût économique et son évolution ainsi que l'impact sur l'efficacité de l'entreprise et son impact social. Refuser le remplacement d'un l'ordinateur sous Windows XP trop vieux pour basculer en Windows 10 au nom de l'environnement peut-être très contre-productif aussi bien en termes de productivité, de motivation du salarié, de risque de cyberhacking.

En revanche, remplacer un smartphone tous les 18 mois pour faire plaisir à un collaborateur est moins essentiel et pourrait être remplacé par des « incentives » ayant moins d'impact environnemental.

Mesurer l’impact environnemental de ses achats et de ses fournisseurs et leur fin de vie

Les entreprises mesurent leur impact environnemental selon le « Scope 1 » (les émissions de gaz à effet de serre directement liées à la fabrication du produit) et le « Scope 2 » (les émissions indirectes liées aux consommations énergétiques). La loi laisse une marge de manoeuvre pour mesurer le « Scope 3 » (les autres émissions indirectes) en les demandant si elles sont significatives.

Le Scope 3 représente souvent 3 à 4 plus d'émissions de Gaz à Effet de Serre que le Scope 1 et 2 réunis et c'est la partie la plus difficile à évaluer car vous devez savoir quel est le scope 1 et 2 de vos fournisseurs qui doivent connaître ceux de leurs fournisseurs … D'autre part, vous devez aussi évaluer l'impact de vos déchets. Si on ne tient pas compte du « Scope 3 », il serait facile de sortir ses émissions de carbone et de les imputer en amont ou en aval par exemple en externalisant ses serveurs.

Pour éviter de vous perdre dans des calculs impossibles, vous pouvez partir sur des canevas d'émissions.

Néanmoins, il faut systématiquement demander à ses fournisseurs et les entreprises collectant vos produits usagés ces informations et s'assurer qu'elles sont cohérentes et détaillées.

(ci-contre le "Scope 3" évalué par L'Oréal)

Donner des outils à ses collaborateurs pour mesurer leurs impacts

Les collaborateurs devraient avoir la possibilité de facilement connaître leur impact environnemental dans l'utilisation de solutions numériques et avoir à disposition des solutions pour les réduire.

Les applications utilisant la vidéo consomment en général plus que les autres. Le pire étant Tik Tok et d'autres applications comme Twitter, Google Chrome sont aussi très gourmandes (cf. EcoCO2).

Des applications comme Mobile Carbonalyser (IPhone – Android, réalisée avec le Shift Project ) peuvent aider à en prendre conscience.

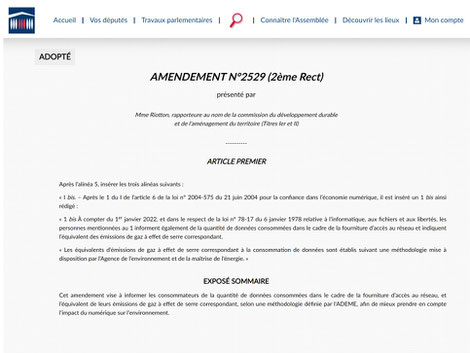

Un amendement du projet de Loi pour l'Economie Circulaire va aussi contraindre les opérateurs à renseigner leurs clients sur la quantité de gaz à effet de serre émise par leur consommation de data mobile via leur facture à partir de 2022. Cela conduirait à les sensibiliser.

L'ARCEP collecte aussi depuis avril 2020, les émissions de gaz à effet de serre produits par les principaux opérateurs de télécommunications sur leurs réseaux et sur la consommation électrique des box utilisés par leurs clients.

Réduire son impact

Lié au matériel et équipements numériques

Les mesures semblent assez simples pour réduire son impact, limiter le renouvellement de son parc télécom, ordinateurs, éviter les accessoires inutiles … Il existe des solutions pour faciliter cette réduction.

La plus commune est la mutualisation, qui est usuelle pour les imprimantes mais difficile à mettre en place pour des smartphones ou des ordinateurs. Toutefois, on peut inciter les collaborateurs à utiliser leur propre smartphone pour un usage professionnel à condition qu'on parvienne à séparer suffisamment les deux environnements (des outils comme Samsung Knox le permettent et des solutions comme OnOff Télécom gèrent les numéros pro et perso sur une seule carte sim ), à réduire les risques de hacking et que le collaborateur y consent. Des avantages salariaux peuvent aussi l'y inciter.

Les accessoires comme les écouteurs Bluetooth dont les AIrpods, les chargeurs sans fils, beaucoup moins efficace qu'une recharge directe (de 40 à 80% de perte d'énergie selon GreenIT)

Les produits achetés peuvent être facilement réparables et évolutifs. Le support SI peut déterminer quelles sont les pannes les plus courantes qui nécessitent le changement d'équipement et choisir les appareils permettant la réparation plutôt que le remplacement. Ils sont moins « hype » que les derniers iPhone ou Samsung, mais les entreprises pourraient proposer des FairPhone à leurs salariés. Leurs produits sont très faciles à réparer y compris l'écran (90€) ou la prise jack par soi-même, sont fabriqués à partir de matières premières « éthiques » ou recyclés en fonctionnement sous Android.

Il existe aussi des labels environnementaux pour vous guider (comme EPEAT, Ecolabel Nordique, L'Ange Bleu. TCO)

A ce titre, l'Union européenne veut instaurer un droit à la réparation des smartphones et tablettes à l'horizon 2021. Elle obligera à rendre les smartphones et tablettes plus durables et faciles à réparer grâce à un meilleur choix des matériaux, une conception adaptée à la réparation, une plus longue prise en charge pour les mises à jour système, et l'instauration d'un nouvel étiquetage avec une note de réparabilité.

Les appareils vendus en Europe devront également favoriser les matériaux recyclés plutôt que des matières premières primaires. La destruction des marchandises durables invendues sera interdite.

Risque de la location

La location paraît a priori la solution préférable à l'achat toutefois il peut créer un effet rebond. Si le montant de la location état indépendant de l'appareil aussi une clause prévoit le renouvellement automatique pour avoir l'équipement le plus à jour, cela incite beaucoup plus l'entreprise à renouveler ses équipements que s'il avait acheté.

D'autre part, il faut s'assurer qu'elle est la seconde vie donnée aux appareils une fois que vous les redonnez à votre prestataire. Pour contrer ce phénomène, on peut imaginer des loyers dégressifs en fonction de l'ancienneté du parc. Cela inciterait beaucoup plus les gestionnaires de flottes à réduire le renouvellement.

Réduire l'impact de ses Data Centers, serveurs, Co-génération et trigénération pour produire du froid à partir de chaleur

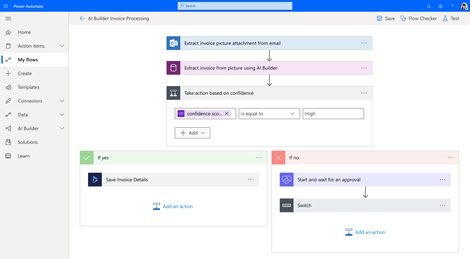

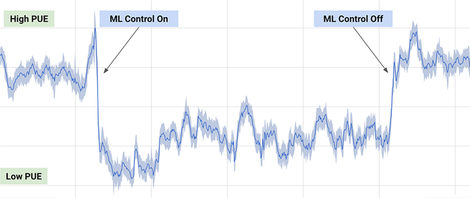

L'usage des serveurs représente une part importante des émissions de CO2 . Une première mesure est l'indicateur d'efficacité énergétique (en anglais PUE ou Power Usage Effectiveness).

Il qualifie l'efficacité énergétique d'un centre d'exploitation informatique. Il quantifie le ratio entre l'énergie totale consommée par l'ensemble du centre d'exploitation (avec entre autres, le refroidissement, le traitement d'air, les UPS (onduleurs)...) et la partie qui est effectivement consommée par les systèmes informatiques que ce centre exploite (serveurs, stockage, réseau).

En été, avec des solutions de trigénération, il est possible de transformer de la chaleur en froid grâce à la réfrigération par absorption

w

Les Européens proposent un autre indicateur appelé DCEM (pour Data Centre Energy Management) qui corrige les défauts du PUE en prenant en compte non seulement la consommation d'énergie et le coefficient d'efficacité énergétique, mais aussi les énergies réutilisées et renouvelables.

Le rapport public « Réduire la consommation énergétique du numérique » le cite comme indicateur à utiliser et propose aussi de nombreuses autres pistes pour réduire l'impact environnemental du numérique.

Dans les appels d'offres, il est essentiel de demander ces deux indicateurs, PUE et DCEM pour l'intégrer dans ses critères de choix.

Point de collecte mixte pro / perso

L'entreprise peut aussi proposer des points de collecte qui servent aussi bien récupérer des équipements professionnels que personnels en panne mais aussi fonctionnels soit pour être donnés ou pour être échangés au sein de l'entreprise. Idéalement, une entreprise peut s'associer avec des entreprises qui vendent de la seconde main (Back Market, Zack…) mais aussi gèrent les réparations, dons aux associations…

Vous pouvez demander conseil à l'éco-organisme Ecologic, ou donner vos produits usagés à des ESS comme Emmaüs Connect. L'objectif est de créer un cycle complet le plus vertueux possible. Il existe aussi plusieurs entreprises en France capables de transformer des déchets électroniques en matières premières réutilisables.

Software et Stockage

Les règles à suivre pour réduire son impact environnemental concernant le stockage sont de ne conserver que ce qui est utile et par exemple par défaut de supprimer les mails antérieurs à une certaine date en particulier si ce sont des newsletters, spams …

On peut empêcher l'envoi de mails et la réception de pièces jointes au-dessus d'une certaine taille ou d'expéditeurs non sollicités (MailinBlack) . Avec des outils comme SmallPdf qui comprime les PDF trop lourds, Smash (équivalent français de Wetransfer) évitant de transférer de gros documents …, on réduit la gêne pour les utilisateurs. On peut aussi activer la compression automatique de ses documents (via NTFS ou en utilisant des outils comme 7-Zip)

Hormis les documents importants qui doivent être gardés, il est préférable de stocker localement ses données et de faire le ménage régulièrement. Des outils intégrant de l'IA facilitent le tri et permettent la déduplication de documents

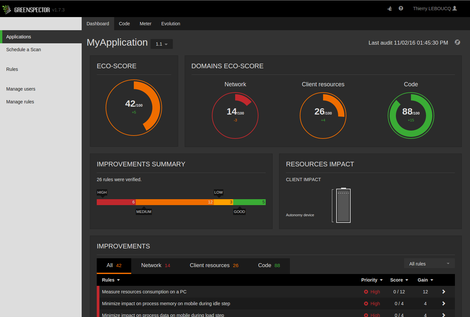

On peut aller au-delà pour les entreprises qui ont l'habitude de coder et développer des outils et applications. La programmation peut être écoresponsable selon qu'on utilise des algorithmes simples, qu'on réutilise des codes déjà optimisés, qu' on utilise peu de données, qu'on recourt rarement des données extérieures. Des entreprises comme Greenspector ou NegaOctet accompagnent les entreprises dans ce domaine.

Greenspector fournit aussi des outils pour mesurer l'efficacité énergétique de son site web.

IA, blockchain, objets connectés, 5G

IA, blockchain, objets connectés sont généralement associés sur le plan environnemental avec forte consultation d'énergie. La question à se poser à chaque fois est en quoi l'utilisation de cette technologie sont utiles, quel est leur impact environnemental, quelles sont les alternatives.

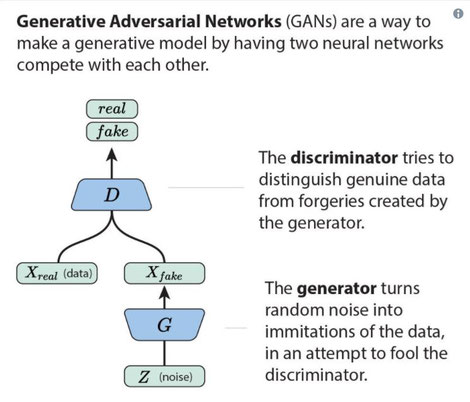

Pour l'IA, la principale cause de consommation d'énergie est l'apprentissage nécessaire pour créer des modèles de réseaux neuronaux. Des techniques comme le transfer learning (cf. article), évite d'entraîner complètement des modèles lorsqu'il existe déjà des modèles génériques pertinents.

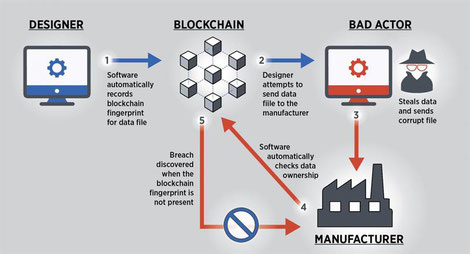

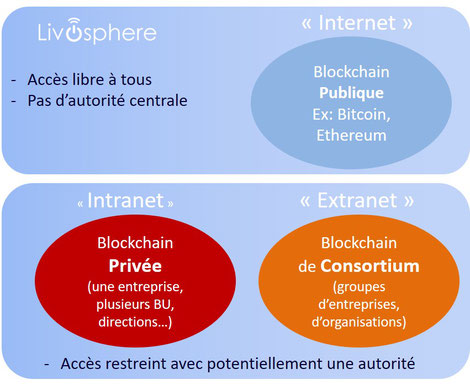

Pour la blockchain, ce sont surtout les blockchains publiques utilisant le « proof-of-work » (comme le Bitcoin et Ethereum ) qui gaspillent énormément d'énergie (cf. article), pour des « blockchain » de consortium ou privées, énergie dépensée est comparable à celles d'autres plateformes digitales.

Enfin, si vous hashez des données tous les jours et mettez le hash sur Ethereum, cela consommera beaucoup moins d'énergie que si vous mettez en place une infrastructure spécifique pour le même usage.

Pour les objets connectés, il faut éviter d'utiliser des objets qui intègrent de la connectivité qui habituellement ne sont pas électriques. Plutôt que d'avoir des chaises connectées, des vêtements connectés, des serrures connectées … il est préférable d'avoir des « add-ons » qui peuvent être utilisés et retirés de ce type d'objets. Cela facilite leur maintenance, leur recyclage et réduit leur impact environnemental. Il faut au préalable s'assurer de la nécessité de les connecter.

Concernant la 5G, un déploiement raisonné et adéquat en fonction de réels besoins a du sens, en revanche la tendance actuelle de remplacer les box Internet par des forfaits illimités est une gabegie (cf. article détaillé )

Numérique, levier environnemental

Partager ses données d’impacts sous forme structurée et en Open source

Il serait utile que les entreprises puissent facilement évaluer l'ensemble de leur impact carbone et plus globalement environnemental sur base de ses éléments financiers.

Créer une comptabilité carbone ou Bilan Carbone est un exercice encore compliqué à réaliser car il n'y a pas de lien direct avec la comptabilité traditionnelle. Il faudrait mettre en place un référentiel (base de données requêtables par des connecteurs API) permettant de facilement créer une correspondance entre des comptes comptables et leur équivalent émissions de CO2 en apportant les précisions nécessaires via l'utilisation par exemple de sous-comptes normés. Il peut en être de même pour les relevés bancaires, chaque vendeur pourrait communiquer l'impact carbone de chaque achat.

Cela faciliterait la comptabilisation du scope 3 (émissions liées aux activités en amont et aval) de l'entreprise en plus du scope 1 et 2 (scope 1 : émissions directes liées à l'activité, scope 2 : Émissions indirectes associées à la consommation d'électricité, de chaleur dans les locaux... ). Je parle plus largement des indicateurs RSE ici.

Avant même une normalisation des données, les entreprises ou fédérations professionnelles pourraient collecter ces informations et créer un « traducteur » en open data entre types de produits et impact CO2 et environnemental .

Dans un certain nombre de cas, cette équivalence sera sans doute insuffisante. Nous pourrions alors à l'image de la comptabilité analytique, développer une comptabilité environnementale et sociale alignée sur la comptabilité générale.

Cela permettrait aussi à chaque entreprise de facilement mesurer et communiquer sur ses émissions GES et leur évolution.

Des applications et des outils simples permettent de suivre ses émissions de CO2 et de la réduire comme Greenly sur base de ses relevés bancaires.

La néo-banque Qonto propose des outils permettant d'automatiser des rapports, relévés grâce à des API, mais pas encore de relevé CO2 Espérons qu'ils intégreront prochainement cette fonction !

Dans un certain nombre de cas, cette équivalence sera sans doute insuffisante. Nous pourrions alors à l'image de la comptabilité analytique, développer une comptabilité environnementale et sociale alignée sur la comptabilité générale.

Cela permettrait aussi à chaque entreprise de facilement mesurer et communiquer sur ses émissions GES et leur évolution.

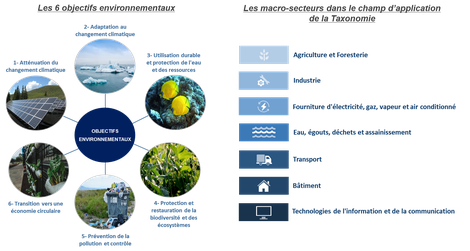

La taxonomie verte, publiée par la Commission Européenne donne un cadre pour distinguer les activités durables des autres sur 70 activités économiques (93% des émissions de GES).

Elle donne des critères qualitatifs et quantitatifs pour déterminer si une activité économique répond à l'un des six objectifs environnementaux et ne pas porte pas atteinte aux autres objectifs (atténuation du changement climatique, adaptation au changement climatique, utilisation durable et protection de l'eau et des ressources marines, transition vers une économie circulaire, prévention et recyclage des déchets, prévention et réduction de la pollution, protection des écosystèmes sains)

Pour les salariés

Il existe de nombreux moyens de favoriser les comportements écoresponsables de ses salariés. Il est toujours préférable de proposer des alternatives adéquates et écoresponsables à des solutions plus polluantes que d'interdire ou dissuader ces comportements sans solutions de repli.

Pour les déplacements, les outils de télétravail, covoiturage courte distance (Karos inclus dans le pass Navigo), écoconduite sont autant de solutions à développer à titre individuel.

Concernant les véhicules électriques, il est préférable d'attendre la fin de l'usage normal du véhicule ( 3 à 5 ans pour une entreprise) que de remplacer l'ensemble de sa flotte par des véhicules électriques.

La fabrication de véhicules électriques est 2 fois plus émettrice de CO2 que la fabrication d'un véhicule à essence (mais cela diminue si on utilise des batteries produites en France et mieux recyclées...). En Europe, il faut environ 23 000 km pour que les émissions de CO2 d'un véhicule électrique neuf soient inférieures à celles d'un véhicule à essence neuf selon Transport & Environment .

En France , ce serait 13 000 km (batterie produite en France) / 29 000 km (batterie produite en Chine). En Allemagne, ce serait 27 000 km (batterie produite en Europe Mix moyen) / 42 000 km (batterie produite en Chine).

En France, si on décide de remplacer un véhicule diesel récent (durée de vie : 225 000 km pour une voiture « medium » selon Transport&Environment) par un véhicule électrique neuf, il faut environ 50 000 km (si la batterie est produite en France) / 65 000 km (pour une batterie produite en Chine) avant que le véhicule électrique émette moins de CO2 qu’un véhicule diesel. En Allemagne, en raison du mix énergétique, il faudrait 75 000 km (pour une batterie produite en Europe mix énergétique moyen) et 92 000 km (pour une batterie produite en Chine).

Cela changera si un jour l’énergie électrique est massivement décarbonée et que les batteries Li-ion sont massivement recyclées mais ce n’est pas le cas aujourd’hui.

En revanche, si votre entreprise produit suffisamment d'énergie via des panneaux solaires par exemple ou la trigénération pour alimenter les véhicules électriques et que les véhicules électriques sont partagés entre plusieurs salariés, ça a tout son sens d'investir rapidement dans des véhicules électriques. Il y a d'autres impacts négatifs des deux côtés, pollution de l'air (oxyde d'azote..) pour les véhicules à essence, et impacts environnementaux (extraction pour les batteries…). Le principal est de faire ses choix en connaissance de cause et de communiquer dessus.

Enfin, n'étant pas à l'abri de pannes d'électricité, il est préférable de diversifier sa flotte si l'entreprise ne peut produire sa propre énergie électrique.

Pour les clients et fournisseurs

De nombreux outils numériques permettent de réaliser de la maintenance préventive et prédictive (ex : Fieldbox.Ai) de réduire les tournées à vide et les déplacements inutiles en sachant là où une intervention sur place est nécessaire et là où elle peut être réalisée à distance. De multiples pannes peuvent être résolues par le client à condition d'avoir des équipements connectés ou des solutions pour connaître le type de panne et les réparer à distance (mise à jour à distance …)

Le « Pricing », la fixation des prix de la maintenance peut aussi être adaptée pour inciter à mutualiser les déplacements ou favoriser les réparations à distance.

Concernant les fournisseurs, vous pouvez leur demander de vous fournir les informations environnementales liées à vos achats et même pour les plus avancés vous donner accès à une plateforme qui liste l'ensemble de vos achats et les traduit sous forme d'impact environnemental sur les étapes : fabrication, transport, usage et fin de vie avec les hypothèses prises. Les fournisseurs pourraient aussi fournir des conseils d'utilisation et sur les différents moyens de gérer la fin de vie de leurs produits (entreprises qui valorise ses produits usagés, plateforme de réparation...) D'ici quelques années, ces informations devraient même être accessibles via des APIs et modulé en fonction de votre comportement (sur la partie usage et fin de vie).

Interne à l’entreprise : Industrie, agriculture…

Les outils de monitoring avec des alertes de consommation excessive, de fuites… et intégrant des conseils personnalisés sont autant de moyens de réduire son impact énergétique globalement.

Industrie

Dans l'industrie, je parle dans l'article suivant de solutions pour écoconcevoir, utiliser l'impression 3D pour éviter d'investir dans des prototypes, des moules , des pièces détachées produits en pure perte.

Iteca permet de concevoir une usine en réalité virtuelle avec les machines en fonctionnement. En s'y baladant grâce à un casque VR, on peut beaucoup plus facilement voir les erreurs de conception, les améliorations à apporter pour réduire les déplacements, les gaspillages …

La relocalisation de certaines usines dès lors qu’elles ont un niveau de rentabilité proche des usines délocalisées sont aussi une belle opportunité pour réduire l'impact environnemental.

L’utilisation de l'intelligence artificielle et de robots collaboratifs peut aider (cf. article - ex: vidéo d'un projet que j'ai réalisé pour une entreprise dans la mode).

Évidemment l'objectif n'est pas de faire une usine sans êtres humains. Ces usines souvent plus petites ont vocation à être beaucoup plus flexibles capables s'adapter au marché plus facilement que des usines situées à des milliers de kilomètres de là.

Dans le domaine du textile et de l'habillement (cf.. article), cela va même jusqu'à bouleverser le modèle économique actuel fondé sur des coûts unitaires très bas grâce à une production dans des pays à bas coûts, des stocks pléthoriques, des invendus en quantité, soldés voire détruits.

Avec la loi AGEC sur les invendus, les industries textiles et habillement devront relocaliser des usines pour que leur production soit ajustée à la demande générant moins de stocks et d'invendus. Certes, les coûts unitaires sont plus élevés en revanche la marge totale par collection est tout à fait comparable avec l'ancien modèle car il y a beaucoup moins de stocks à gérer et d'articles à solder qui dégradent fortement la marge globale.

Agriculture et autres domaines

Dans le domaine agricole, l'utilisation de drones associée à la spectrographie et la géolocalisation permet de savoir de manière beaucoup plus précise quelles sont les parcelles à traiter et de réduire fortement l'utilisation de pesticides, de suivre la production d'aliments, de détecter des maladies foliaires et des adventices.

Il existe bien d'autres usages, le principe est d'identifier les gaspillages, les pertes de ressources, de temps, les déchets … de pouvoir les mesurer suffisamment tôt, d'identifier et de mettre en place des solutions pour les réduire ou à défaut réduire leur impact négatif.

D'autre part, ces solutions ont souvent un impact économique positif et peuvent nécessiter des modifications dans le modèle économique. Le plus courant est le passage d'un modèle de vente de produits à un modèle de vente de services. Michelin vend ainsi l'usage et la gestion des pneus pour les transporteurs plutôt que les pneus.

Ils intègrent des services (gestion de parc, rechapage, remplacement…) qu'un transporteur n'a pas la possibilité de développer seul. Michelin a agrégé et mutualisé le retour d'expérience de ses clients pour proposer un service adapté à leurs besoins.

Conclusion

On voit qu'il est assez facile de lancer une stratégie de sobriété numérique tout en l'associant avec des outils utilisant le numérique comme levier environnemental. Pour réussir les projets il est nécessaire d'avoir le soutien de la direction, d'associer les collaborateurs, clients et fournisseurs.

Il existe de très nombreuses solutions pour aider une entreprise dans cette stratégie, toutefois au lancement, il est utile d'être accompagné pour structurer la démarche, prioriser et évaluer les différentes solutions, éviter la dispersion des énergies et un retour au business as usual. Les ressources internes sont souvent enthousiastes au début mais peuvent être découragées au bout de quelques mois. C'est la raison pour laquelle une ressource externe peut grandement aider à transformer une initiative en axe directeur pour l'entreprise décliné en actions à court terme et projets à long terme.

Si vous êtes intéressé par mettre en place cette stratégie dans votre entreprise, vous pouvez me contacter directement ici ou par mail contact@livosphere.com.

Dimitri Carbonnelle - Fondateur de Livosphere

Conseil en Innovation durable (RSE / Économie circulaire), Numérique (IA, IoT...) - Contact contact@livosphere.com

Conférences, Formation, Project Lead de projets innovants - Vidéos

De la recherche d'innovations, de startups à leur déploiement et accompagnement dans vos projets

Numérique, levier pour l'environnement, la RSE, l'économie circulaire et Sobriété Numérique (5G, IA...)

La technologie est de plus en opposée à l'environnement. Les débats se polarisent pour ou contre l'IA, la 5G, les énergies renouvelables ... (English version) (voir aussi article sur la stratégie RSE à adopter sur le plan numérique)

Sans doute, nous nous trompons dans l'ordre des questions. La première question n'est pas "faut-il ou pas développer telle ou telle technologie ?" Elle est "Où voulons aller ?" puis nous avons les bases pour savoir quelles sont les technologies sont adéquates ou non pour y parvenir. Or, il manque encore cette vision de la direction que nous souhaitons prendre, il manque cet imaginaire que nous souhaitons que les futures générations vivent. La réponse n'est pas dans les technologies mais dans les relations entre les hommes, les femmes, la Nature qui nous entoure.

Concernant les technologies et le numérique, nous pouvons sortir des idéologies stériles qui vacillent entre les "techno-béats" et les "techno-bashers" vers une position médiane empreinte d'un peu de bon sens. Le numérique et l'environnement peuvent être des leviers l'un pour l'autre et ne sont pas nécessairement en contradiction comme le donnerait à croire des raisonnements simplistes.

Il y a deux axes sur lesquels nous pouvons agir : encourager la sobriété numérique c'est-à -dire réduire l'impact environnemental du numérique et transformer le numérique en vrai levier pour l'environnement

Je commencerai par le dernier qui selon moi aura le plus gros impact car il touche tous les domaines de notre société.

(Pour avoir des sensibilisations, formations même à distance générales ou liées à votre secteur, vous pouvez me contacter ici : contact@livosphere.com ou ici ) Nous menons aussi des projets RSE, sur la sobriété numérique notamment.)

Sommaire (Lien direct vers les parties d'articles)

Numérique, levier pour l'environnement

- Circular data hub, ressources d'économie circulaire

- Intégrer dans le Circular data hub, les données des déchets des industriels

- Référentiel d'émission CO2 directement lié au Plan comptable général

- CirculScore, Nutriscore pour les emballages

- Développement de boîtes à outils digitales destinées aux collectivités.

- France Relance - 1 Mds € pour relocaliser et investir dans des usines et machines polyvalentes

- Impact des relocalisation sur l'environnement, l'empreinte carbone, dépendances

- Investissement dans des cobots, robots collaboratifs

- Favoriser l'impression 3D pour faciliter la personnalisation de masse et réaliser les réparations

- Informations publiques sur les risques environnementaux, Startups et acteurs français

Sobriété numérique - Réduire l'impact du numérique

- Rapport du Sénat : Bonnes propositions et deux non pertinentes

- Forfaits mobiles à 80 Go, 100 Go pour 15€ !

- 5G, remplaçant les box Internet fibre ?

- Avoir un déploiement raisonné de la 5G

-

- Augmentation du débit, Réduction de la latence, Que faire ? Un usage raisonné de la 5G

- Faciliter l'accès à notre impact environnemental numérique

- Intégrer des indicateurs d'efficacité énergétique dans les appels d'offres publics sur l'hébergement des données

- Développer l'ordinateur quantique, le Transfer learning et les modèles open source afin de réduire la consommation énergétique de l'IA

- « Digital Shadow Governement »

Numérique, levier pour l'environnement

Circular data hub, ressources d'économie circulaire

Nous pourrions créer un Circular data hub où l'ensemble des ressources d'économie circulaire géolocalisées seraient accessibles en open data (lieu de réutilisation, réparation, ressourcerie, magasin en vrac...).

L'intérêt de permettre aux particuliers et aux entreprises de savoir où facilement réparer, réutiliser, recycler leurs déchets en fonction de leur localisation. Une startup Hoali cartographie déjà un certain nombre de ces informations pour les particuliers. En réduisant au maximum les frictions à la réutilisation, recyclage des produits, nous accroîtrons la part de l'économie circulaire par rapport à l'économie linéaire.

Cela n'est pas d'ailleurs réservé aux informations d'économie circulaire mais aussi aux données RSE (impact en termes d'émissions CO2 , biodiversité, ACV, inclusion)

Pour éviter de nombreuses études, des informations pourraient être structurées et mises à disposition d'entreprises en plus des organisations publiques comme l'ADEME pour être utilisable facilement (via des API ...)

Intégrer dans le Circular data hub, les données des déchets des industriels

Lors de la fabrication de nombreux produits, des déchets sont rejetés (produits défectueux, chutes de textile, de cuir, matières premières en excès) avant même la commercialisation des produits finis.

Nous pourrions fortement inciter les entreprises à mettre à disposition les données sur leurs déchets industriels disponibles (géolocalisées, caractérisés). Comme ces informations sont sensibles car elles permettent potentiellement de retrouver les secrets de fabrication, d'avoir des données sur l'activité des entreprises (source potentielle de délits d'initiés), elles devraient être « anonymisées » ou disponibles seulement pour des acteurs spécialisés dans la réutilisation et le traitement des déchets tout en assurant auprès des industriels, la sécurisation de leurs données.

Nous travaillons sur ce sujet avec une designer d'économie circulaire, et une fondatrice d'une startup qui termine son mémoire sur la symbiose industrielle. Notre objectif est de créer des filières circulaires avec tous les partenaires qui souhaitent se joindre à nous dans cette démarche.

Référentiel d'émission CO2 directement lié au Plan comptable général

On parle régulièrement de comptabilité carbone ou Bilan Carbone, néanmoins cet exercice est encore compliqué à réaliser car il n'y a pas de lien direct avec la comptabilité traditionnelle. Il faudrait mettre en place un référentiel (base de données requêtables par des connecteurs API) permettant de facilement créer une correspondance entre des comptes comptables et leur équivalent émissions de CO2 en apportant les précisions nécessaires via l'utilisation par exemple de sous-comptes normés.

Cela faciliterait la comptabilisation du scope 3 (émissions liées aux activités en amont et aval) de l'entreprise en plus du scope 1 et 2 (scope 1 : émissions directes liées à l'activité, scope 2 : Émissions indirectes associées à la consommation d'électricité, de chaleur dans les locaux... ). Carbone 4, dirigée par Jean-Marc Jancovici réalise ce type de diagnostic. Je parle plus largement des indicateurs RSE ici.

Dans un certain nombre de cas, cette équivalence sera sans doute insuffisante. Nous pourrions alors à l'image de la comptabilité analytique, développer une comptabilité environnementale et sociale alignée sur la comptabilité générale.

Cela permettrait aussi à chaque entreprise de facilement mesurer et communiquer sur ses émissions GES et leur évolution.

CirculScore, Nutriscore pour les emballages

A l'image du Nutriscore, qui permet d'évaluer la qualité d'un aliment, nous pourrions ajouter un « CirculScore » pour noter la facilité de réutilisation, recyclabilité de l'emballage d'un produit consommable.

Il existe déjà un indice de réparabilité qui sera mis en place pour les appareils électroménagers grâce à Loi pour une Economie Circulaire. L'objectif est que la notion de réutilisation à défaut de recyclage puisse devenir un critère d'achat systématique pour les consommateurs.

Informations publiques sur les risques environnementaux

Il existe plusieurs portails nationaux qui permettent de savoir exactement pour votre domicile quels sont les risques d'inondations et autres risques (glissements de terrain, installations industrielles, pollution des sols ... ) : Georisques et Infoterre.

Chaque collectivité pourrait communiquer sur les risques auprès de ses habitants et entreprises ainsi que sur les mesures de prévention collectives et individuelles qu'ils peuvent prendre. Ils pourraient aussi solliciter d'autres territoires et entreprises pour les aider à y faire face.

"France Relance", relocalisation investir dans des usines et machines polyvalentes

Le plan de relance nommé "France Relance" couvre spécifiquement la relocalisation et l'innovation. et consacre 15 Mds€ à cet effet. Sur ces 15 milliards, 1 milliard d’euros serviront à des “aides directes construites avec les industriels pour permettre sur des projets très précis d’apporter une aide de l’État".

L'enjeu pour l'Etat sera d'éviter des projets de relocalisation "à l'ancienne" en implantant des usines traditionnelles. Au contraire, celles-ci doivent d’une part intégrées des technologies innovantes comme l’IA, les cobots mais aussi savoir être polyvalentes. La pandémie Covid-19 a montré à quel point la reconversion rapide de certaines unités de production a été essentielle pour produire du gel hydroalcoolique et des masques. La non-spécialisation des machines permet beaucoup plus facilement de reconvertir une usine à de nouvelles tâches de production et éviter les impasses dans lesquelles se trouvent beaucoup de petites villes industrielles qui ont des usines tributaires de marchés spécifiques. Enfin, il est nécessaire d'inclure l'emploi local, le territoire dans ces investissements et éviter les implantations "hors-sol" à la manière d'es entrepôts Amazon. Il doit y avoir un engagement des industriels à s'engager dans le territoire où ils s'implantent (associations, environnement, aménagement), intégrer une démarche RSE territoriale.

Cette relocalisation aurait un impact positif et les cobots et l'impression 3D sont quelques exemples de machines polyvalentes.

Impact des relocalisation sur l'environnement, l'empreinte carbone, dépendances

Le transport de marchandises ou fret maritime représente 2,5 % des gaz à effet de serre sur le plan mondial. Le transport aérien de fret est proportionnellement beaucoup plus réduit mais important pour des secteurs comme le luxe.

Un des moyens de réduire fortement les émissions de CO2 est de rapprocher la fabrication de biens du consommateur et donc de relocaliser des usines aujourd'hui souvent très éloignées comme l'a révélé la pandémie du Covid-19. Par exemple, 60 à 80% des principes actifs des traitements comme les antibiotiques, les anticancéreux et les vaccins proviennent de Chine.

Cet éloignement met aussi en lumière notre dépendance vis-à -vis de pays qui peuvent avoir des intérêts divergents des nôtres et s'en servir comme moyen de pression diplomatique. Notre double dépendance vis-à -vis des Etats-Unis et de la Chine représente un vrai risque d'écartèlement pour l'Europe.

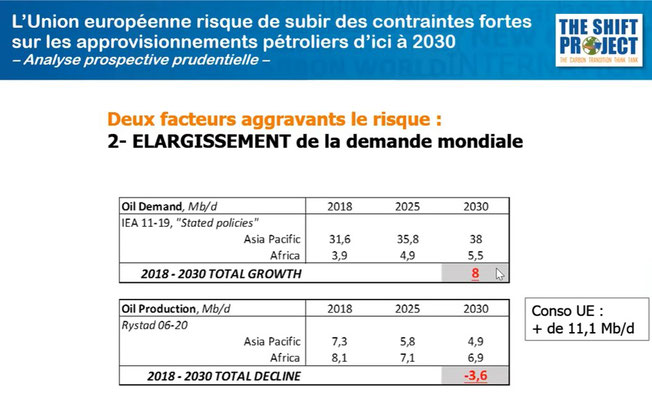

D'autre part, il y a selon The Shift Project mené par Jean-Marc Jancovici, un vrai risque que d'ici 2030, l'Europe soit confrontée à une chute de ses ressources en pétrole. (cf. video)

54 % de ressources en pétrole proviennent de pays qui vont voir leurs ressources pétrolières diminuer (pays en rouge dans le graphique) alors que les besoins en pétrole sur le plan mondial devraient s'accroître avec le risque de tensions géopolitiques qui en résulteraient.

L'impact devrait se faire sentir à partir de 2026.

Investissement dans des cobots, robots collaboratifs

Pour réduire cette dépendance et nos émissions de CO2, nous pouvons relocaliser un certain nombre d'usines. Le problème est évidemment le coût de la main d'oeuvre en France qui est bien supérieur à celui des pays asiatiques.

Pour y remédier, nous pouvons favoriser l'adoption des robots collaboratifs (cobots) capables de produire de manière polyvalente des biens adaptés aux clients finaux (à la différence des robots industriels).

Le suramortissement possible pour les PME à hauteur de 40% de leurs investissements dans la robotique, les logiciels et les machines de production effectués est un premier pas mais cela ne couvre pas le coût de l'intégration qui double généralement le prix total de l'investissement.

Idéalement, il faudrait aussi que les industriels fabricant ces cobots soient européens, voire français. De nombreuses startups comme IsyBot et Mip Robotics se développent sur ce créneau ainsi que des intégrateurs spécialisés.

Ces derniers sont indispensables pour adapter la solution cobotique avec les besoins spécifiques de l'usine. Si vous souhaitez creuser ce sujet, j'ai réalisé un projet de déploiement de cobots, et j'ai décrit de manière détaillée la démarche que j'ai adoptée.

Favoriser l'impression 3D pour faciliter la personnalisation de masse et réaliser les réparations

En plus des cobots, l'impression 3D permet aussi de réaliser de la personnalisation de masse à la demande tout en minimisant les ressources utilisées.

Cette personnalisation associée à l'exigence d'instantanéité des clients peut profondément transformer les circuits de fabrication des produits. Cela oblige à réduire fortement les délais et les distances entre le consommateur final et la production du produit (cf. article).

Si un industriel commande des centaines de milliers de pièces en Asie (notamment pour réduire le coût des transports et les coûts unitaires de fabrication) et qu'il n'est pas en capacité de les écouler, il se retrouve face à un énorme stock qu'il ne pourra plus, à juste titre jeter à partir du 31/12/2021 pour les produits couverts par un régime REP (responsabilité élargie du producteur) et au plus tard le 31 décembre 2023 pour les autres produits. (mesure sur les invendus non alimentaires de la loi anti-gaspillage pour une économie circulaire).

L'impression 3D évite de créer des moules chers pour de grandes séries et permet de créer des petites séries beaucoup plus proches du consommateur ( fog manufacturing ).

Seb l'utilise aussi pour réduire la quantité de pièces détachées stockées pour une partie inutilement afin de respecter la garantie du constructeur.

L'impression 3D en revanche n'est pas utilisable pour tout car il est nécessaire d'utiliser une matière extrudable (qui permet à un liquide / matière visqueuse de s'écouler par une buse et qui se solidifiera à l'air libre) ou d'une matière (résine ou poudre) qui se solidifie par laser.

Enfin, même si de plus en plus de produits issus de l'impression 3D sont recyclables et utilisent des matériaux biosourcés (startup FrancoFil) et même des déchets plastiques (startup 3Devo), il ne sont généralement recyclables que quelques fois et les produits multi-matériaux sont difficiles à recycler.

Sur le plan économique, le coût unitaire de fabrication est significativement plus élevé qu'une fabrication traditionnelle, d'où la nécessité d'avoir une vision totale des coûts en amont et en aval.

Développement de boîtes à outils digitales destinées aux collectivités.

Il existe de nombreuses solutions pour réaliser les diagnostics sur le plan environnemental et aider ainsi les collectivités à bien cibler leurs investissements ainsi que des solutions pour les aider à réduire l'impact environnemental des individus et des entreprises. Malheureusement, il n'y a pas encore suffisamment de partage entre elles.

Un des axes du secrétariat d'Etat chargé du Numérique en concertation avec le ministère de la Transition écologique et le ministère de la Cohésion des territoires et des Relations avec les collectivités territoriales pourrait être de mettre à disposition des boîtes à outils digitales intégrant des portails d'informations locales et des solutions d'entreprises à destination des collectivités et accessibles aux particuliers, entreprises, organisations.

A l'image du portail Cybermalveillance qui permet de réaliser un diagnostic en cas d'attaques numériques et vous propose des solutions et professionnels capables d'y répondre, ce portail aurait un rôle très opérationnel, faciliterait le partage d'initiatives et la recherche de solutions.