Comme chaque année, je réalise des prédictions sur l'année qui suit et les quelques années qui suivent car j'ai tendance à un peu trop anticiper certains événements. (Pour des conférences, cliquez ici - In English)

En 2019, j’avais traité le sujet de l’Humanité aux pieds d’argile et comment créer une société résiliente « en boule de gui », en 2018, l’Inflexion exponentielle des technologies, la Confusion (Homme-Artificiel, Vrai-Faux), et Confrontation entre Etats, GAFA, BATX, Individus, Planète

Le fil rouge pour cette année est la place de la Tech dans nos sociétés. 2020, sera une étape charnière pour la technologie, nous avions parlé d'une sympathique Tech for Good et avons dépassé ce cap car aujourd'hui devant le réchauffement climatique, les inégalités sociales…, nous sommes face à un dilemme : Tech for Gods ou Tech Bashing. Je suis partisan d’une technologie qui prend en compte plus la dimension humaine, locale, durable, et qu'elle soit proportionnée au problème.

En résumé mes prédictions sur les nouvelles technologies sont :

- IA : massification de la « pervasive IA », combinée avec la blockchain, l’IoT … utilisant moins de données, plus attentive aux données personnelles et à réduire la consommation énergétique (federated et transfer learning, edge AI). IA éthique, émergence des IA architectes ou méta-IA et aux IA personnelles, portabilité des modèles

- Blockchain et crypto-monnaies / monnaies digitales : Brique parmi d’autres, Digital Yuan, monnaie des routes de la soie, IoT plus interopérable

- 5G pas d'explosion en B2C à la différence des usages en entreprise (Critical IoT : Industrie, véhicules, e-santé) qui devraient émerger mais avec une couverture bien moindre que la 4G

- Quantique – Quantum Washing et montée de la cryptographie post-quantique

- Génie génétique, l’arrivée des xenobots, organoïdes, génétique synthétique

- Rappel sur le changement climatique ... Passer de 37 Mdt équivalents à CO2 à 0 en 20 à 30 ans ...

- Géo-ingénierie sur le devant de la scène malgré les risques

- Risques de démocratisation des Tech for Gods (« Black Ball ») et comment les réduire

- Lassitude vis-à-vis de la technologie

- Fragilité de notre société et notre dépendance vis-à-vis d’elles

- Perte de contrôle face aux technologies et notamment pour les emplois

Technologie plus humaine, locale, écologique, proportionnée au problème

- Partir du problème et non de la solution

- « Impact Crowns » - Couronne d’impact sur le plan sociétal, environnemental et économique

- Favoriser les comportements positifs et dissuader les comportements néfastes

- Vers une approche locale fondée sur des solutions partagées et mutualisées, low tech

- Imaginer un Futur souhaitable en 2050 pour les moins de 20 ans fondée sur la collaboration, la responsabilisation des citoyens et des communautés, l’éco-responsabilité, la diversité dans le respect de l’autre

- Emergence d’une société complémentaire en boule de gui à notre société actuelle

Quelques autres prédictions :

Not too good

Quelques prédictions pour 2020 :

- Accroissement massif de l’influence digitale de la Chine et dans une moindre mesure de la Russie avec la montée du nombre d’utilisateurs non asiatiques d’applications chinoises (ex TikTok), lancement du Digital Yuan qui dans quelques années pourraient être la nouvelle monnaie d’échange sur les nouvelles routes de la soie et pour les pays hyper-inflationnistes.

- Forte augmentation (au minimum +50%) du coût de l’énergie sur le plan mondial (ex : pour l’électricité : 0,3 € / kWh sur le plan européen versus 0,2€ aujourd’hui ) liée à une taxation beaucoup plus forte et une forte augmentation des prix du pétrole (raisons géopolitiques mais plus incertaines à cause de la surproduction de gaz de schistes )

- Entrée dans la phase exponentielle de bouleversements climatiques dans un monde de plus en plus vulnérable : inondations, incendies, perte d’accès à l’électricité, Internet, télécom sur de périodes dépassant le mois … Après avoir bénéficié de l’inertie climatique pour ralentir les impacts humains sur notre planète, l’inertie commence à avoir un effet accélérateur négatif

Comment y faire face ?

Aujourd'hui, 2050 sont devenus les années repoussoir avec son flot de catastrophes, effondrements, ravages annoncés dus notamment à l'utilisation de certaines technologies ! 50 ans avant, l'imaginaire collectif sur les années 2000 était plein d'espoir, de rêves nourris par la Science-Fiction, de progrès technologiques bien sûr exagérés et erronés sur différents plans mais qui donnait envie de les vivre. Il en est tout autrement aujourd'hui.

Entre les films Retour vers le futur et Ready Player One, le contraste est saisissant !

Tout ça ne paraît pas très enthousiasmant, je termine donc par mes dernières prédictions pour répondre à ces problématiques :

Nouvel imaginaire pour 2050

- Emergence d'un nouvel imaginaire désirable pour les nouvelles générations qui vivront dans une société « post-consumériste »

Si les moins de 20 ans ne veulent pas périr de désespoir, ils peuvent créer et communiquer sur leur propre imaginaire de la société dans laquelle ils aimeraient vivre, différente de celle de leurs aînés. C'est cet imaginaire que des hommes et femmes comme Greta Thunberg doivent propager et construire plutôt que de perdre leur énergie à demander aux anciens de renier leur imaginaire.

ll y a beaucoup de débats sur les positions de Greta Thunberg lors de son passage à l'ONU ou à Davos.

Greta Thunberg est un peu la "Laurent Alexandre" du climat, son rôle est de nous faire prendre conscience de l'urgence climatique. Les leviers les plus forts pour y réussir sont la peur et le désespoir, domaines dans lequel elle sait exceller.

Mais on ne peut pas demander à Greta de devenir la Gandhi, la Martin Luther King du climat. D'ici un an ou deux, émergeront d'autres figures charismatiques, qui prendront la relève de Greta. Après cette première prise de conscience (merci Greta), elles nous emmèneront mondialement vers l'action au pas de course. Elles seront porteuses d'une transformation drastique de nos modes de consommation (encore très majoritairement fondée sur la consommation de masse, la mobilité carbonée, l'agriculture intensive...). Elles seront capables de faire bouger les lignes des États, des entreprises et changer nos comportements individuels. Avant Martin Luther King, il y a eu de nombreuses personnalités, Rosa Parks, Linda Brown, qui chacune ont contribué à transformer notre société. Greta est juste la première incarnation de ce bouleversement.

Soyons à l'écoute, découvrons et favorisons l'émergence de la Gandhi, la Martin Luther King du climat. Certaines personnalités jailliront et incarneront la métamorphose de notre société en se fondant sur des actions de masse partagées et non plus sur une peur collective.

- Emergence d'une société complémentaire voire parallèle qui deviendrait un filet de sécurité si notre société pyramidale et fondée sur l'économie de marché défaillait. Elle serait fondée sur 4 principes :

1. la collaboration (de pair à pair, dans une communauté et entre communautés)

2. la responsabilisation des citoyens et des communautés (en anglais : " Citizen et community empowerment ") qui permet de décentraliser des décisions, moyens, ressources à la bonne maille et être responsable (" accountable ") de ses décisions (positives et négatives)

3. l'éco-responsabilité, utilisation de la low tech (tech utile, durable et accessible) et la high tech là où c'est vraiment pertinent

4. la diversité (indispensable pour faire émerger des idées nouvelles, être plus résilients, solidaires) dans le respect de chacun

L'objet de ces prédictions n'est pas d'avoir raison mais plutôt qu'on se pose les bonnes questions, à chacun ensuite d'y répondre. Nous rentrons dans un cycle de 20/30 ans qui devrait s'accélérer et profondément transformer nos sociétés, nos vies, notre consommation.

Nous vivons le début d'une crise existentielle de nos civilisations plutôt qu'un effondrement.

Rassurons-nous, il y a les JO 2020 et les élections américaines cette année, qui sait nous aurons peut-être de très bonnes nouvelles qui compenseront peut-être le lot de mauvaises nouvelles 😉

Tech for Good, Prévisions sur les avancées de l'IA ...

Avant de commencer à voir tous les problèmes posés par les nouvelles technologies voyons mes prédictions à ce sujet et ce qu’elles peuvent faire de bien en 2020 !

IA : massification, IA architectes, données personnelles.

Massification de l'IA invisible

Elle se démocratisera de manière visible et surtout invisible en s'intégrant de plus en plus, dans notre quotidien dans nos logiciels et nos smartphones.

Dans nos TV, l'IA réalise déjà de l'upscaling, dans nos smartphones l'IA améliore la qualité des photos ou redresse notre tête quand on l'utilise avec FaceTime. Nos radiateurs, équipements électroménagers devraient réduire leur consommation, nous alerter avant les pannes et communiquer avec nous pour des usages précis, grâce à l'IA embarquée dans des puces pour des prix dérisoires.

Le partenariat de Snips (reconnaissance vocale & NLP embarquée aujourd'hui rachetée par Sonos) par NXP illustre cette tendance en proposant des puces capables de gérer les échanges vocaux spécifiques. Les lunettes classiques intégrant un assistant vocal intelligent (ou juste un espace pour l'intégrer) devraient faire florès comme l'illustre Amazon avec Echo Frames et Bose Frames.

De nouvelles interfaces homme-machine se développeront (ex: interfaces Brain-to-Command performantes comme NextMind captant et décodant avec l'IA le point d'attention à partir des flux électriques à la surface du crâne ).

Clinatec avait déjà montré leur dispositif, Wimagine qui permet à une personne tétraplégique de se déplacer grâce à son exosquelette. On utilise ses intentions de mouvement (interprétées par les signaux électriques du cerveau un Brain Computer Interface (BCI), dispositif médical qui mesure en haute résolution l'activité électrique dans le cerveau)

L'année dernière, BrainCo montrait ses premières prothèses de main utilisant la modulation de l'influx nerveux dans les moignons pour faire bouger chacun des doigts, cette année au CES Las Vegas, je peux même serrer sa main. L'IA est utilisée pour traduire un influx nerveux déclenché par le cerveau en geste et aide les personnes à compenser leurs handicaps. L'IA apprend du cerveau humain qui s'adapte à l'IA qui apprend du cerveau humain...

Capacités en croissance exponentielle et une aide précieuse

L'IA devrait rentrer dans une phase exponentielle en termes de capacités d'analyse, de découverte et de création. Les scientifiques sont souvent confrontés à la masse de données collectées lors de leurs expériences, de leurs découvertes. L'IA va devenir une aide indispensable pour eux pour faire le tri des données, trouver les perles rares mais aussi identifier les erreurs.

Récemment, une IA créée par Google a su prouver plus de 1200 théorèmes mathématiques (déjà prouvés 😉 ) avec un taux de réussite de près de 40% après avoir été entraînée sur plus de 10 000 théorèmes. Une IA a pu sur base de textes scientifiques anciens prédire les meilleurs matériaux thermoélectriques modernes grâce à du text-mining. Une IA d'une équipe du MIT a su traduire avec une précision de 67% une langue ancienne, le Linéaire B, forme ancienne et archaïque du grec.

Les Etats devraient aussi en profiter pour débusquer les comportements illicites et les fraudeurs. Le fisc français peut identifier les fraudeurs (limité aux activités occultes, domiciliations fiscales fictives, trafics illicites)... comme l'a autorisé le Conseil Constitutionnel, avec un certain nombre de garde-fous (ex : conservation limitée à 5 jours, recours interdits aux sous-traitants pour l'exploitation ou la conservation des informations personnelles).

Certains se disent qu'il suffit de ne plus poster publiquement des photos à côté de son véhicule pour passer à travers les mailles du filet. Ce serait bien naïf. Certaines IA sont capables de déterminer votre orientation sexuelle avec une forte probabilité sur base de vos likes même si vos likes n'ont aucun lien apparent avec votre orientation sexuelle. (cf. documentaire : Comment Trump a manipulé l'Amérique sur Arte) et intervention de Yuval Harari si un algorithme lui avait prédit qu'il était gay à 15 ans plutôt qu'il ne s'en rende compte à 21 ans).

Le principe est assez simple, si des groupes de personnes ayant des caractéristiques communes likent plus particulièrement certains types de posts par rapport à une population ne les ayant pas, on peut en déduire sur base des likes, la probabilité qu'ils aient tel type de comportement.

Avec 10 likes, on serait capable de mieux vous connaître qu'un collègue de travail, avec 100, mieux que vos proches et amis, avec 230, mieux que votre compagne/compagnon ... Il ne vous reste plus qu'à regarder combien de Like publics vous avez laissé sur Facebook, Instagram, Twitter ...

Pour entraîner l'IA, il faudrait idéalement identifier les posts des fraudeurs existants et connus du fisc et les corréler avec leurs likes néanmoins le Conseil Constitutionnel n'a pas autorisé à recourir à ce dispositif pour les cas de contribuables coupables d'un défaut de déclaration et déjà sous le coup d'une mise en demeure. Ca devrait donc ralentir la phase d'apprentissage 😉

Néanmoins, le fisc veut porter à 35 %, la part des contrôles ciblés par l'IA en 2020, contre 13,85 en 2018.

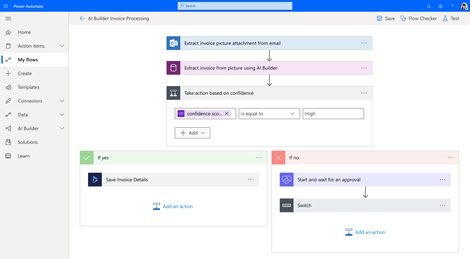

Démocratisation de l'IA au sein des entreprises et programmation par l'IA

Google met à disposition des outils de plus en plus simples pour permettre aux entreprises de créer leurs propres IA (avec AutoML ou AutoAI). Ces briques logicielles déterminent par elles-mêmes les modèles de machine learning et de deep learning, en fonction des besoins et des données d'entraînement disponibles. Ces offres se généralisent chez Google, Microsoft, Amazon, Datarobot et plein d'autres comme chez la startup française Prevision.io qui était au CES 2020 et présentera une nouvelle mouture de son outil.

De plus, le codage sera de plus en plus simplifié grâce à l'IA avec des solutions low-code ou No Code qui auront des performances de plus en plus proches de codeurs professionnels. Le métier de codeur se transformera en architecte de solutions d'IA car l'IA va être capable de programmer par elle-même. En revanche, on aura toujours besoin de quelqu'un pour spécifier ce qu'elle doit programmer et lui donner les lignes directrices et les lignes rouges à ne pas dépasser.

Combinaison de l'IA avec l' IoT, Quantique, blockchain, génétique .

L'IA sera combinée massivement avec d'autres technologies les objets connectés, la blockchain, la robotique, le quantique même.

L'IA combinée avec la génétique et la robotique permettrait de réaliser les thérapies géniques à des coûts bien moindres, à condition bien sûr que les labos pharmaceutiques acceptent de réduire leurs marges bénéficiaires (généralement leurs marges nettes sont supérieures à 20% et peuvent dépasser les marges bénéficiaires (Lien 2018) d'un certain nombre de groupes de luxe en %.).

Les robots industriels intègreront massivement la vision augmentée par l'IA pour adapter leur comportement (j'ai réalisé un projet de robots collaboratifs pour une entreprise de mode. Voici un lien vers une étude de cas qui décrit sa mise en place).

Dans les processus administratifs, la RPA ou Robotic Process Automation (avec des entreprises comme UI Path, Blue Prism, Automation Anywhere et plus récemment Microsoft avec UI Flows) permet d'automatiser des tâches répétitives et intègrent de plus en plus des briques d'IA à différents niveaux. Pour transformer des données non structurées en données structurées, la RPA utilise l'OCR pour la reconnaissance de caractères, le traitement du langage pour l'analyse de mails.

Pour s'assurer que le processus ne déraille pas, l'IA s'assure que les données utilisées ne sortent pas d'une enveloppe normale de données usuelles ou qu'il n'y a pas d'incohérence entre les données. Pour les cas inhabituels, la main serait redonnée à un être humain.

Imaginons qu'une date de naissance 1/1/1982 soit transmise dans un formulaire pour solder sa retraite aujourd'hui, une RPA classique ne verrait pas l'erreur sauf si cela a été codé en amont. Une IA serait capable d'identifier cette incongruité sans que personne ne lui indique qu'il y a potentiellement une erreur dans son programme car l'IA verrait qu'un très faible nombre de dossiers ont une année de naissance aussi récente. On utilisera des techniques d'apprentissage non supervisé, afin de grouper des caractéristiques de données similaires et d'identifier des écarts inhabituels.

Petit rappel, il n'est pas nécessaire d'utiliser des réseaux neuronaux pour faire cela, des technologies de data clustering permettent de le faire aussi. L'IA permet d'avoir une finesse et d'identifier des clusters moins évidents dès lors qu'on a une quantité de données suffisante.

Il ne serait d'ailleurs pas étonnant que les IA apprennent à utiliser des techniques classiques de statistique et " supervisent " automatiquement leur utilisation. Cela éviterait de dépenser du temps et des ressources pour entraîner un réseau neuronal pour trouver de simples corrélations linéaires !

Utiliser moins de données nécessaires ou en générer automatiquement

Une des problématiques de l'IA, plus précisément des réseaux neuronaux avec apprentissage supervisé est d'avoir des données labellisées de bonne qualité et en nombre pléthorique.

Pour identifier un chat dans une image, il ne suffit pas d'avoir des images de chat, il faut labelliser chaque image pour indiquer celles où il y a un chat et si possible où il se trouve. Cela prend énormément de temps et de nombreuses entreprises indiennes se sont spécialisées dans ces micro-tâches (grâce notamment à la plateforme Amazon Mechanical Turk). Les grandes avancées de l'IA consistent à réduire le temps nécessaire à labelliser les données. Il existe de plus en plus de techniques, par exemple

- en utilisant une IA qui va montrer des images qu'il a pré-catégorisées, l'humain ne fera juste qu'un travail de vérification pour les cas limites,

- créer de nouveaux sets de données grâce à la conception 3D qui permet de simuler une multitude de lumières, d'angles de vue, de textures... à partir d'un seul objet conçu en 3D,

- créer des univers virtuels dans lesquels interagissent les objets en intégrant les lois physiques. Les moteurs de jeux créés par Ubisoft par exemple seraient très utiles pour entraîner des IA dans des mondes virtuels ainsi que ceux de Dassault Systèmes (même s'ils ne font pas encore.)

Une autre technique est de prendre des contenus avec plusieurs formats d'un même contenu et entraîner une IA capable de traduire l'un dans l'autre. Jean Ponce (ENS) utilise l'audio-description des films pour labelliser les scènes (les objets, les événements ...) (ex : un homme passe à côté d'un piano alors que la femme regarde Sam)

Techniques pour réduire la consommation énergétique et les risques de hacking

Plutôt que de réinventer la roue à chaque fois, c’est-à-dire réentraîner des réseaux neuronaux à partir de rien, les IA fondées sur les réseaux neuronaux vont utiliser de plus en plus les technologies de Transfer Learning et Federated Learning (ou apprentissage fédéré).

Transfer Learning

Le transfer learning permet de passer d'un modèle généraliste et de le spécialiser, il s'entraîne sur des domaines spécifiques beaucoup plus rapidement et avec moins de données. Par exemple, un réseau neuronal apprendra à distinguer des espèces de fleurs à partir d'un réseau neuronal capable de distinguer les fleurs.

C'est la technique utilisée par NextMind pour en une minute être capable d'apprendre où vous portez votre attention grâce à son casque car ils ont entraîné leur IA avant avec un très grand nombre de données.

Comme l'amélioration de l'apprentissage est linéaire quand la base croît exponentiellement, cela signifie que cela coûte en ressources et en données des bases beaucoup plus importantes pour passer d'un taux de fiabilité de 80% à 85% que d'un taux de 92% à 97%. La mutualisation de bases génériques (comme Imagenet) associée au transfer learning, permet de minimiser ces impacts ainsi que le croisement de données de sources diverses et indépendantes. Si dans un véhicule autonome, vous avez trois sources de données indépendantes indiquant à 80% qu'il y a un piéton devant lui, la probabilité que ce soit un piéton est de 1 - (1-0,8)^3 = 99,2%. Cela nécessite certes d'ajouter des capteurs indépendants et d'intégrer de l'IA (sensor fusion) mais cela coûte moins cher que d'avoir un seul équipement parvenant lui-même à avoir un taux de fiabilité de 99,2%.

Federated Learning

Le Federated Learning évite de transmettre ses données brutes pour entraîner un réseau neuronal global "mère" sur base de réseaux neuronaux "filles".

On entraîne un réseau neuronal localement et on ne transmet que les paramètres de ce réseau neuronal au réseau neuronal global qui les utilisera pour s'améliorer. Cela évite en particulier de transmettre des données brutes (ex : données clients, opérationnelles...) et réduit donc les risques de fuite de données. La startup Cosmian utilise cette technologie associée avec le chiffrement homomorphe pour " garantir " la sécurité des données

Differential privacy et chiffrement homomorphe

Il existe d'autres techniques comme l'agrégation de données entre plusieurs personnes et la Differential privacy (la confidentialité différentielle en français) pour assurer la confidentialité des données. Le chiffrement homomorphe permet d'entraîner un réseau neuronal sur base de données que vous aurez cryptées.

En phase de production, vous cryptez vos données en entrée, les faites passer par votre modèle d'IA qui les transforme en résultats cryptés. Vous seul pourrez les déchiffrer avec votre clé de décryptage. Néanmoins la qualité de l'apprentissage est bien moindre et nécessite beaucoup plus de données que l'apprentissage classique.

Edge AI, IA local

Pour éviter de transmettre des données, l'exécution et même l'apprentissage peuvent en partie se réaliser sur des équipements locaux grâce à la forte croissance de puissance de calcul des processeurs IA et le développement de puces neuromorphiques spécialement conçues pour l'apprentissage de l'IA.

Cela permet de respecter le RGPD et réduit la consommation énergétique.

Même combat : Green AI, RGPD, Cybersécurité

Réduire les entraînements superflus d'IA et la consommation d'énergie grâce au transfer learning, réduire les transmissions de données dont personnelles, les risques de hacking et la consommation énergétique avec le federated learning et l'Edge AI sont quelques techniques qui permettent d'adresser ensemble les impacts environnementaux, la protection des données, la cybersécurité.

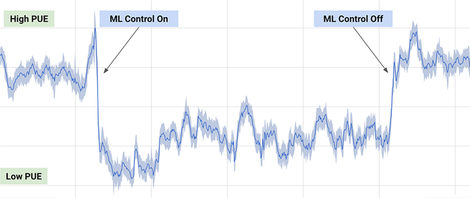

Leur développement et la création de nouvelles (comme les IA architecte cf. ci-dessous) vont devenir vitaux dans les prochaines années si on veut éviter un rejet de l'IA en raison de ses conséquences négatives sur la planète et les individus. Google a d'ailleurs utiliser Deepmind pour réduire sa consommation énergétique dans ses serveurs.

Au début, il y a du greenwashing mais nous devrions converger vers du vrai Green AI. Cela est d'autant plus crucial qu'une IA sans électricité vaut autant qu'une puce grillée !

Combinaison : IA connexioniste (Réseau neuronal) et IA symbolique (moteurs de règles)

Beaucoup de data scientists ne jurent que par le deep learning alors qu'il y a des techniques beaucoup plus simples et rapides.

Appliquer le deep learning, c'est comme utiliser la force brute, tester une multitude de combinaisons pour résoudre un problème mathématique. Un peu de raisonnement suffit souvent amplement !

Or l'IA n'est pas une mais multiple, entre IA symbolique (nommé aussi GOFAI Good Old Fashioned AI : moteur de règles) et connexionniste (réseaux neuronaux notamment). Les deux démarches sont différentes, la première, top-down, la deuxième bottom-up.

L'utilisation combinée des deux, associée aussi aux outils statistiques traditionnels devrait fortement s'accélérer en 2020. IBM qui aujourd'hui a exclu sa branche IA symbolique, ex-Ilog, de sa solution IBM Watson devrait la réintégrer cette année, selon moi car d'ici peu, les deux types d'IA seront intimement liés.

L'intérêt majeur de la combinaison des deux est de nécessiter moins d'énergie et de données. En fonction du type de données et de leur quantité, structurées ou pas, labellisées ou pas, du résultat attendu on peut utiliser les réseaux neuronaux (full CNN, réseaux convolutionnels pour les images, les RNN pour les analyses temporelles, les LSTM ( Long short-term memory) pour le traitement du langage et NLP ...), les réseaux bayésiens, les algorithmes génétiques ... les moteurs de règles et arbres de décisions .... Leur combinaison nous fait entrer dans une fractale d'IA... On ne sait plus très bien quel type d'IA est au-dessus de l'autre.

Méta IA - IA Architecte

La question est comment construire une solution IA cohérente avec une telle complexité et la gérer ?

Comme l'illustre les conclusions de l'accident d'Uber , l'intégration de multiples sources de données avec des décisions potentiellement contradictoires est particulièrement complexe. Pour un véhicule autonome, la probabilité qu'un événement extrêmement rare pour un véhicule survienne est très forte s'il est étendu à l'ensemble des véhicules circulants. Ce n'est pas parce qu'il n'y a quasiment aucune chance de gagner au loto, qu'il n'y a jamais de gagnants ! Le raisonnement est vrai dans le sens inverse.

Et ce n'est pas tout, pour créer une IA performante, il faut avoir des données propres et si possible structurées. Il faut aussi adapter la présentation des données en fonction du contexte, de l'utilisateur et contrôler la pertinence des décisions des différentes IA.

Vu la complexité de préparation et traitement de données, il devient de plus en plus compliqué à un être humain et même à une équipe multi-spécialiste d'intégrer, construire une solution complète d'IA.

Les méta-IA ou IA architectes devraient fortement se développer à partir de 2020, elles concevront des solutions d'IA de plus en plus complètes avec la capacité de les adapter en temps réel.

Une approche pertinente serait d'avoir un réseau neuronal " architecte " qui testerait des algorithmes traditionnels, moteurs de règles... et des sous-réseaux neuronaux pour résoudre un problème. Une fois entraînée, une autre IA aurait pour rôle de le rendre explicable voire de le transformer en nouveau moteur de règles capable de s'adapter ou en réseau d'agents. Au fur et à mesure, ces IA architectes pourraient manipuler de nouvelles compétences comme la programmation d'interfaces utilisateur en HTML, Python... Microsoft présentait récemment Power Automate et Power Virtual Agents qui sont une première viision de ce que ce sera.

Ces IA architectes sont les précurseurs de l'AGI, intelligence artificielle générale capable de rivaliser avec les êtres humains.

IA éthique : transparentes, explicables et éthiques

Ces méta-IA ne suffiront pas pour tout gérer car l'IA ne sait pas prioriser par elle-même. La vie d'un être humain a autant de valeur qu'un bit 0 ou 1. Nous devrions intégré des règles éthiques dans les IA pour quelles puissent prioriser un minimum et éviter les non-sens.

En 2020, les IA explicables et des techniques pour les rendre explicables et l'émergence d'IA éthiques devraient fortement se développer. Il est très difficile de distinguer la frontière entre une IA éthique et non-éthique, d'autant que selon notre culture, le contexte, les utilisateurs, ce qui est éthique un jour, ne l'est plus le lendemain. Vérité en deçà des Pyrénées, erreur au-delà...

Une première approche a été réalisée par le groupe d'experts européens HLEG qui ont défini une checklist accessible dans 23 langues . L'objectif est de se poser les bonnes questions quand on met en place une IA.

Une approche complémentaire est de rendre les IA " transparentes " et de les rendre explicables. On a tendance à dire que le deep learning n'est pas explicable et est une boîte noire, ce n'est pas tout-à-fait exact. On peut caractériser de manière approchée un algorithme de deep learning.

Dans l'exemple ci-contre, on entraîne un réseau neuronal à détecter le type d'animaux. En cachant des parties d'images de manière réitérée et en vérifiant ce que l'IA détecte dans une image, on est capable de déterminer les zones utilisées par l'IA pour détecter qu'il y a un mouton, une vache...

De la même manière, on peut vérifier les biais de sélection dans une IA qui trierait des CV en cachant des informations ou en remplaçant des informations par d'autres (adresse, âge, homme/femme). Si le tri de CV est fortement différent si on inverse la donnée entre hommes et femmes, il y a un fort biais lié au genre des candidats. L'IA peut déduire ces informations du prénom, des activités extra-professionnelles, voire de la structure même du CV pour mieux détecter les biais. Il faut alors au préalable vérifier toutes les données corrélées au genre et les cacher ou les randomiser afin de mesurer les biais de l'IA. By th way, c'est encore le boulot d'être humain de faire cette recherche.

La perte de ces informations peut potentiellement réduire la qualité du tri d'où la nécessité d'avoir régulièrement des audits et tests de l'IA et une vérification terrain des CV choisis et non choisis.

Même aux Etats-Unis, ils ont conscience des risques de biais puisqu'une loi sera bientôt présentée au Congrès américain à ce sujet par les sénateurs Cory Booker (D-NJ sur la photo) and Ron Wyden (D-OR) et le soutien de Yvette Clarke (D-NY) (Analyse et PDF : Algorithmic Accountability Act : "an algorithmic accountability bill was introduced to the US Congress that would require certain algorithms to be regularly reviewed for signs of bias."). D'autre part, la sénatrice Maria Cantwell (D-WA) et des collègues démocrates ont proposé un vaste projet de loi sur la confidentialité des données qui obligerait les entités couvertes à auditer certains systèmes de "prise de décision algorithmique" qui utilisent l'apprentissage automatique (ML).

L'enjeu est majeur car l’IA peut soit être utilisée comme aide à la décision avec la supervision d'un être humain soit comme outil de décision automatisée. Pour le tri de déchets, une IA intégrée dans une caméra prenant des décisions automatiques pour trier dans un bac à plastique ou en carton paraît évident. Il en est tout autrement dans la prise de décision d'accepter ou refuser un crédit (interdit par le RGPD, tout décision doit être motivée et au final donnée par un être humain) voire pour prendre une décision de justice comme c'est en train de se passer en Chine avec le crédit social.

Pour les personnes intéressées, j'ai réalisé un MOOC spécifique à ce sujet avec EMLyon sur l’IA et la prise de décision qui couvre notamment ces problématiques.

IA personnelle

Aujourd'hui, l'IA que nous utilisons provient d'entreprises externes en particulier les GAFAM, à l'image des données personnelles, il devrait commencer à y avoir un mouvement des consommateurs et citoyens afin que chacun puissions avoir une IA personnelle que nous entraînions.

J'avais écrit il y a quelque temps un article à ce sujet (en 2011, Jamais son mon iLad ...) et je vais réaliser une intervention en juin dont voici le teaser en vidéo avec CamélIA, ma future IA personnelle 😉.

L'objectif est que nous puissions avoir une forme de "contre-pouvoir" face aux IA fournies par les entreprises.

C'est encore un peu tôt mais d'ici quelques années, nous pourrions avoir un droit à avoir et garder une IA personnelle comme aujourd'hui nous avons un droit sur nos données personnelles.

Un risque majeur est qu'une entreprise sur base de données personnelles ou " para-personnelles " (ex : likes, navigation sur Internet...) même non stockées puisse créer un jumeau numérique de notre comportement. Elle n'aurait plus besoin de ces données personnelles pour nous connaître et anticiper notre comportement, son modèle suffit. Quid alors de notre droit concernant ce modèle personnel d'IA, de sa portabilité, de l'information du client. C'est un sujet que devrait adresser la CNIL. A l'inverse, une IA personnelle pourrait brouiller les pistes, créer un écran de fumée pour ne pas créer ce double digital.

Portabilité des modèles d'IA et propriété juridique

Plus près de nous se pose la question de la propriété des modèles d'IA et de la portabilité de ceux-ci pour poursuivre leur entraînement. IBM, à ma connaissance garde la propriété des modèles d'IA même s'ils ont été entraînés avec des données clients. Cette position est intenable et devient inacceptable pour la plupart des entreprises.

De plus en plus de sociétés réalisant des modèles d'IA pour des clients donnent la propriété de ceux-ci à ces derniers. Cela pose néanmoins des questions de propriété intellectuelle dès lors qu'une IA a été entraînée avec de multiples sources de données, clients, externes, open-source... et qu'il est très difficile de démêler l'écheveau.

Néanmoins, peu d'entreprises peuvent poursuivre l'entraînement de leurs modèles d'IA si elles cessent leur relation commerciale avec leur prestataire d'IA même si les clients possèdent le modèle.

Nous évoluerons certainement vers une portabilité des modèles d'IA comme le permet d'ailleurs le format ONNX soutenu par Microsoft.

Blockchain et crypto-monnaie (digital yuan, euro et monnaies locales)

Un des points faibles de la blockchain (cf. mon article à ce sujet) est sa consommation d'énergie et sa lenteur de transaction pour les blockchain publiques (permissionless lié au mode de consensus : Proof of work extrêmement consommateur d'énergie).

Pour cette raison, on verra plus l'émergence de blockchains de consortium (permissioned) qui nécessitent beaucoup moins d'énergie et sont beaucoup plus rapides car les entités qui valident les transactions sont choisies à la différence des blockchains publiques qui peuvent être validées par tous.

La blockchain devrait voir ses usages s'étendre de manière invisible sur des usages B2B comme l'authentification, la traçabilité notamment alimentaire et des emballages (cf. ma proposition dans la Loi pour une économie circulaire à ce sujet).

Elle deviendra plus une brique qu'une solution complète. Des données peuvent être partagées dans une base de données décentralisée entre de nombreux participants et être régulièrement hachées et intégrées dans une blockchain publique afin d'assurer sa traçabilité ultérieure.

Combiné avec l'IA, la blockchain et les smarts contracts pourraient voir le développement des premières entreprises autonomes (nommés DAO)

Concernant les crypto-monnaies, je suis assez circonspect sur l'avenir de celles provenant d'acteurs privés. La Libra de Facebook aura beaucoup de mal à sortir après la vague de départ de partenaires (cf. article détaillé) et de l'opposition des Etats et banques centrales. En revanche, les crypto-monnaies et les monnaies digitales devraient être développées par les Etats et les banques centrales.

Digital Yuan et Digital Euro

Malgré le fiasco de la première crypto monnaie d'Etat, le Petro, projet de "stablecoin" vénézuélien, deux projets majeurs devraient être lancés en 2020, le Digital Yuan, monnaie digitale d'Etat annoncée par le gouvernement chinois (en réalité elle n'est pas fondée sur la blockchain mais utilise certains de ses principes comme la traçabilité) et le "Digital Euro", crypto-monnaie appuyée sur l'Euro et directement gérée par les banques centrales des pays membres de l'Union européenne.

Le Digital Yuan a aujourd'hui un usage domestique et a vocation à remplacer le Yuan, la monnaie fiduciaire. L'intérêt est évidemment de permettre une traçabilité de toutes les transactions et de pouvoir " saisir " facilement les digital yuan des Chinois mal notés ce qui est plus compliqué avec l'argent liquide... On n'arrête pas le progrès !

Aucune autre crypto-monnaie n'est autorisée en Chine. L'autre potentiel du digital yuan, d'ici quelques années est son utilisation dans les échanges commerciaux en particulier avec les pays bénéficiant d'infrastructures sur les " nouvelles routes de la soie " et les pays en voie de développement qui ont une très forte inflation et une monnaie très instable comme au Venezuela.

L'intérêt est que le yuan devienne petit à petit une monnaie de référence sur le plan international entièrement contrôlé par la Chine et contrer à terme le dollar (10% des échanges commerciaux sont chinois mais le yuan représente 2% des paiements). Le terme approprié de la monnaie chinoise est en réalité, le renminbi, le yuan est l'unité primaire du Renminbi mais c'est le terme utilisé généralement ( 1 yuan vaut 10 jiao). Il est envisageable que certains pays dépendants doivent payer en Digital Yuan pour commercer avec la Chine, ce qui faciliterait sa convertibilité aujourd'hui limitée.

L'utilisation des cryptomonnaies aurait aussi du sens pour créer des monnaies locales potentiellement "sponsorisées" par les collectivités locales afin de favoriser le commerce local. Un usage inattendu de la blockchain est le jeu vidéo avec Nine Chronicles, un RPG totalement décentralisé, ce qui réduit les risques de blocage en cas de panne centralisée de serveurs.

Pour plus d'éléments sur la blockchain, vous pouvez regarder mon article spécifique dessus.

IoT pour plus d'interopérabilité dans la smart home

L'IoT devient aussi de plus en plus une brique permettant de capter des données ou d'agir. L'IoT dans le B2B explose en termes d'usages et permet d'énormes gains de productivité (évite les pannes, déplacements inutiles, optimise la gestion des ressources) et s'associe beaucoup avec l'IA gourmande en données.

En B2C, l'émergence de standards dans la Smart Home est très longue à venir mais devrait peut-être arriver comme le montre la nouvelle alliance " Project Connected Home over IP ", avec Zigbee Alliance (qui intègre Legrand, Somfy, Samsung) et de nombreux acteurs Apple, Amazon, Google et Zigbee Alliance.

J'ai fait de nombreuses prédictions erronées sur l'arrivée de normes de communication dans la maison (avec Thread de Google notamment). La principale difficulté est l'incroyable hétérogénéité des objets, usages, accès à l'électricité ... et des occupants dans un logement qui rend les standards extrêmement longs à mettre en oeuvre car il s'agit de standards multilatéraux transsectoriels (équipement de la maison, éclairage, sécurité, télécoms, énergie, mobilité ...).

Ma prévision est donc que cela prendra encore beaucoup de temps pour que des standards se démocratisent.

5G : Le soufflé va retomber en B2C, usages en B2B en « Critical IoT »

Il y aura beaucoup de "hype","buzz" médiatique autour de la 5G, c'est une innovation qui changera la donne (plus robuste et moins de latence nommé URLLC) surtout pour des usages spécifiques comme l'industrie, la télé-médecine, le véhicule autonome et connecté.

En revanche, la 5G restera une innovation incrémentale avec un modèle économique incertain pour les opérateurs télécoms concernant l'augmentation de débit (nommé eMBB pour les usages : 360°, AR/VR) et surtout l'IoT à bas débit et faible consommation d'énergie (nommé mMTC) car les solutions existantes comme NB-IoT, LTE-M, Sigfox, Lora répondent à 80% / 90% du besoin

Les restrictions appliquées à Huawei devraient aussi pénaliser le développement de la 5G car les infrastructures Huawei étant subventionnées par la Chine (Le prix des équipements Ericsson et moins cher que Huawei en Chine) sont moins chères à déployer et donc réduit d'autant le ROI des opérateurs. Vous trouverez une analyse plus complète de la 5G dans mon article sur le CES Las Vegas 2020 .

Quantique - Quantum Washing et montée de la cryptographie post-quantique

Nous entrons dans la phase Hype de l'informatique quantique avec une 1ère phase de "Quantum-Washing" comme il y a eu de l'IoT, l'IA et la blockchain washing.

Des principes fondamentaux de la physique quantique comme la superposition des états, l'intrication, la réduction du paquet d'ondes sont la source des futurs usages du calcul quantique : la parallélisation massive de calcul en particulier combinatoire (le premier pas a été les GPU par rapport aux puces traditionnelles, ), la simulation d'interactions chimiques, moléculaires (ex : la compréhension du repliement des protéines ) qui dépendent eux-mêmes de la physique quantique, la sécurisation des échanges.

L'Union européenne a d'ailleurs lancé un projet OPENQKD pour développer une infrastructure de télécommunication de clés de cryptage quantique.

Le premier intérêt de l'ordinateur quantique est de résoudre les problèmes ayant des multitudes de combinaisons en un temps polynomial plutôt qu'exponentiel (ex : le problème du voyageur de commerce). Cela pose d'ailleurs inversement un souci pour toutes les technologies fondées sur l'impossibilité actuelle de calculer en un temps raisonnable la solution à un problème mathématique comme la décomposition d'un nombre en ses 2 nombres premiers. Ce problème est la base des techniques de cryptage actuelles comme AES 512 bits utilisé pour crypter les données dans une blockchain.

Cela deviendra un risque majeur en particulier pour les services bancaires avec des risques de fuites de données et de piratage. Il devrait y avoir donc des investissements massifs dans les prochaines années dans les techniques de cryptage post-quantique, résistantes aux ordinateurs quantiques, plus rapidement encore que l'ordinateur quantique. Une phase de recryptage de données avec ces techniques deviendra nécessaire afin d'éviter le décryptage des données historiques.

Nous n'y sommes pas encore ... Google et IBM se tirent la bourre, le 1er ayant déclaré la suprématie quantique contestée par le 2e . La suprématie quantique signifie le moment où un ordinateur quantique dépasserait très largement un ordinateur classique en puissance de calcul et est évaluée à plus de 50 qubits.

Le Sycamore de Google serait capable de réaliser en environ 200 secondes un calcul qui nécessiterait environ 10.000 ans sur un superordinateur classique sauf qu'IBM affirme qu'il peut réaliser ce calcul en 2 jours et demi.avec un supercalculateur classique (en ajoutant 64 Po de SSD et. 7 racks de data-center. Merci Olivier pour la précision ;). D'autre part, le problème résolu par l'ordinateur quantique de Google n'a aucune application concrète et est spécialement conçu pour des ordinateurs quantiques.

IBM utilise le terme de " volume quantique " (qu'il est seul à utiliser) pour désigner la capacité de calcul d'un ordinateur quantique. Cela regrouperait tous les facteurs pertinents, à savoir, le nombre et la connectivité des qubits, la profondeur de l'algorithme utilisé ainsi que d'autres mesures telles que la qualité des portes logiques, notamment le bruit du signal.

Il y a loin de la coupe aux lèvres, avant d'industrialiser, de fiabiliser et surtout de pouvoir utiliser des ordinateurs quantiques avec des applications concrètes, il faudra sans doute une dizaine d'années minimum. Le périmètre d'utilisation du calcul quantique est aujourd'hui très restreint aujourd'hui. Nous verrons une phase de création d'algorithmes quantiques et de programmation quantique qui seront fondamentalement différents de la programmation actuelle mais qu'ils ne pourront s'appliquer qu'à un certain nombre de problèmes mais pas la totalité comme le laisserait croire certains médias.

L'ordinateur quantique ne remplacera jamais les ordinateurs actuels en revanche d'ici 20 ou 30 ans, les puces quantiques pourraient remplacer les GPU et processeurs neuromorphiques qui réalisent des calculs fortement parallèles et seront une de leurs composantes. Le jour où NVidia lance sa première puce quantique, nous pourrons alors parler de vraie révolution quantique. Je vous recommande d'ailleurs l'excellent e-book d'Olivier Ezratty à ce sujet

Génie génétique, l'arrivée des xenobots, organoïdes, génétique synthétique

Nous aurons quelques surprises avec le génie génétique en 2020 bonnes et moins bonnes ... avec l'émergence de langages de programmation génétique.

Nous pourrions tout à fait imaginer d'ici quelques années écrire en Python ou son équivalent biologique afin de créer les premiers automates cellulaires pour traiter tel ou tel type de maladie génétique ou soigner des patients atteints de maladie virale.

Nous sommes déjà aux prémices de cette programmation.

Au début de cette année a été créé le 1er xenobot, robot programmable basé sur des cellules de grenouille. Après de très nombreuses simulations numériques (Deep Green) pour aboutir à des modèles viables, des scientifiques ont construit des organismes capables de se mouvoir, de déplacer d'autres organismes ... et aussi capables de se réparer tout ça à partir de cellules souches de peau et de muscle de xenopus laevis, des grenouilles qui vivent habituellement en Afrique.

On pourra parler vraiment d'organismes vivants lorsque ces xénobots seront capables de se reproduire ...

D'autres chercheurs ont créé un système CARVER (Cas13-Assisted Restriction of Viral Expression and Readout), qui combine SHERLOCK, un " outil biologique " qui diagnostique et mesure les niveaux d'ARN viral dans un échantillon avec l'enzyme CRISPR -Cas13 pour identifier des mutations cancéreuses ou détecter des virus sur des échantillons génétiques et les traiter. Ils sont parvenus à réduire de plus de 300 fois l'infectivité du virus de la grippe et pourraient éliminer d'autres virus à ARN comme Ebola et la grippe.

Verra-t-on un jour des BPI (biological programming interface) équivalents des API (application programming interface) dans le monde de la santé ? Je n'en doute pas une seconde ... On risque de voir Google prochainement sur le sujet !

Vu comme le vivant et les virus ont une capacité d'adaptation phénoménale, ce serait ballot que ces virus modifiés se retournent contre nous ... Nous devons avoir une utilisation très spécifique et encadrée de ces remèdes pour éviter la même erreur que les antibiotiques. On les administre de manière préventive pour les animaux d'élevage ce qui a grandement facilité l'émergence de super-bactéries résistantes à l'ensemble des antibiotiques existants. Je vous laisse imaginer les conséquences d'une grippe et Ebola résistante à tout vaccin ... Espérons que le Coronavirus ne prenne pas ce chemin.

On verra aussi de nombreuses alternatives à CRISPR émerger comme les gènes sauteurs qui évitent les problèmes d'off-target de Crispr (gène découpé au mauvais endroit...) ainsi que le développement d'organoïdes. Ce sont des " mini-organes " formés à partir de cellules souches, ou de cellules progénitrices un peu plus différenciées, qui s'auto-organisent dans un environnement 3D adapté (hydrogel...).

L'intérêt est de pouvoir étudier de manière beaucoup plus proche de la réalité, le fonctionnement d'un organe ou d'un tissu biologique et de passer à la 3D à la différence des boites de Pétri en 2D. Aujourd'hui, de nombreux animaux sont utilisés pour tester des traitements, les organoïdes permettraient de rendre la recherche animale plus efficace, précise et ciblée, et donc diminuera le nombre d'animaux utilisés mais l'organoïde ne remplacera pas l'animal entier. Sinon, ce serait une forme de clonage.

Des chercheurs de l'université de Californie sont même parvenus à recréer un mini-cerveau avec un réseau de neurones fonctionnel où apparaissent des oscillations cérébrales synchronisées.

La génétique synthétique devrait voir ses premières applications dans le stockage de données et la traçabilité. Des chercheurs suisses ont synthétisé un " ADN " synthétique qui code l'information de conception d'un objet, ils l'ont encapsulé dans des billes de silice nanométriques résistantes à la chaleur et diffusées dans la matière.

En l'occurrence, ils ont imprimé un lapin en 3D avec cette matière " augmentée ". En prélevant n'importe quelle partie du lapin, on est capable de récupérer l'ensemble des informations nécessaires à sa conception à l'image de l'ADN vivant. Dans cet " ADN " digital qu'ils nomment " DNA-of-things storage architecture ", ils ont stocké 45kb d'informations mais sont montés jusqu'à intégrer une vidéo de 1,4 MB qui peut être extraite de n'importe quelle partie d'objet dès lors que les billes de silices sont bien réparties dans toute la matière.

Les usages sont nombreux, le stockage des dossiers de santé électroniques dans des implants médicaux, la traçabilité et l'authentification d'objets comme des sacs, des emballages et l'intégration du mode de fabrication d'un objet intégré dans la matière même de l'objet.

En revanche, il y a plusieurs limitations, cet " ADN digital " est fixe et non dynamique, il n'est pas " vivant ", il ne se réplique pas par lui-même et sa fabrication reste à ce stade artisanal et non industrie

Tech for Gods

Avec toutes ces technologies, l’Homme risque de se prendre pour un dieu capable de résoudre d’une baguette magique l’ensemble des problèmes.

Quelques rappels sur le changement climatique

Aujourd'hui, nous émettons 37 Md de tonnes d'équivalent CO2 par an dans le monde et il faudrait les réduire à 0 d'ici 2055 pour n'avoir que 2° C de plus. Le GIEC indique qu'aujourd'hui nous augmentons la température de 0,2°C par décennie (avec les émissions actuelles) et que nous avons déjà augmenté la température de 1°C.

Ce qui signifie qu'au minimum, si nous ne faisons rien et s'il n'y a pas d'effet d'accélération (réduction de l'albédo, dégazage de méthane venant du permafrost...), en 2050, il devrait y avoir 1,6°C de plus (et ce ne serait qu'un début...)

Enfin si nous arrêtons de produire aujourd'hui des GES, l'impact sera perceptible dans 20 ans ... L'augmentation de température est liée au cumul de GES émis depuis l'ère pré-industrielle, donc en arrêtant nos émissions, nous ne faisons que limiter l'augmentation de température ... Arrêter d'émettre des GES, c'est un peu comme payer les intérêts de ses emprunts sans s'endetter plus, en revanche, on reste toujours aussi endetté !

Géo-ingénierie sur le devant de la scène malgré les risques

Pour inverser la tendance, il faudrait réduire la quantité de GES accumulé ... un des nouveaux terrains de jeu de la géo-ingénierie. Le GIEC le définit comme " l'ensemble de méthodes et de techniques visant à modifier délibérément le système climatique pour lutter contre les effets du changement climatique " et cela aiguise de nouveaux appetits. La géo-ingénierie peut atteindre d'autres objectifs comme augmenter la bio-diversité, ou les ressources en eau, ici on parlera de " Climate Intervention " plus précise.

Il y a deux moyens d'intervenir actuellement pour réduire le réchauffement climatique soit éliminer et séquestrer le dioxyde de carbone, soit réduire le rayonnement solaire absorbé par la Terre.

Eliminer et séquestrer le dioxyde de carbone

Pour éliminer et/ou séquestrer le carbone, nous pouvons augmenter la capacité des puits naturels de carbone (boisement/reboisement, bioénergie avec utilisation de la biomasse végétale stockant du CO2 pour produire de l'énergie en séquestrant le CO2 produit, Captage direct du dioxyde de carbone dans l'air, Minéralisation du carbone pour le stocker sous forme solide, Stockage géologique en injectant le CO2 dans une formation géologique).

Les 4 technologies les plus matures sont le boisement/reboisement, la gestion des forêts/champs, le stockage dans les sols agricoles et la bioénergie avec captage et stockage du dioxyde de carbone.

Une des plus gros projets est le "Great Geen Wall", "construction" depuis 2007 d'une Grande Muraille Verte de 8000 km au sud du Sahara constitué grâce à la plantation d'arbres. 15% a déjà été réalisé et permet aussi d'enrichir les sols et incitent les populations à rester sur leurs terres.

D'autres projets ressemblent plus à du green-washing lorsqu'elles ne sont pas encadrées. Replanter un arbre pour compenser ses émissions carbone est souvent un pis-aller car il faut quelques années pour compenser des émissions déjà réalisées par la croissance d'un arbre.

S'il n'y a aucun suivi de ceux-ci, ils resteront des plants d'arbres voués à disparaître qui ne compenseront même pas l'énergie pour les planter.

Si les arbres sont brûlés ou tombent naturellement, le stockage du CO2 n'aura duré que quelques décennies au plus... si aucune séquestration du CO2 n'est prévue.

Ensemencement en fer des océans

Les plus gros risques viennent d'autres techniques comme l'ensemencement en fer des océans afin d'accélérer la croissance du phytoplancton responsable du captage du CO2 de l'atmosphère

L'objectif est d'accroître la quantité de carbone capturée et stockée par les océans et pour des sociétés privées, notamment américaines, de gagner des sommes mirifiques ... : le stockage du carbone devait permettre d'obtenir des crédits d'émissions pouvant être revendus sur les marchés carbone !

Très mauvaise idée en réalité car si les océans captent 25% des émissions de CO2 anthropiques, l'essentiel du captage se fait via un processus physique de dissolution du carbone dans l'eau selon Stéphane Blain, chercheur au Laboratoire d'océanographie microbienne (CNRS) et une grande partie du gaz carbonique est rejetée lors de la décomposition de ces algues microscopiques à la surface !

Heureusement, un moratoire sur les projets utilisant de telles techniques a été adopté par 191 pays dans le cadre de la Convention sur la diversité biologique de l'ONU.

Alcaliniser les eaux de surface avec de la chaux

On pourrait contrer le processus d'acidification en alcalinisant les eaux de surface. On relancerait du même coup, la pompe à carbone. Mis à part quelques études financées notamment par l'industrie pétrolière, cette pratique n'a pas encore été testée in vivo. (Source Les Echos)

Pour éviter les ouragans qui se forment dans une eau à plus de 25° C, l'entreprise américaine Intellectual Ventures a breveté un système consistant à faire flotter dans l'océan d'immenses tubes de 300m de long et de 200m de large, pour les plus imposants, permettant, grâce à la houle, de mélanger les eaux du fond avec celles plus chaudes de la surface dans le but de les refroidir et d'éviter ainsi les ouragans.

Réduire le rayonnement solaire absorbé par la Terre nommé GRS, gestion du rayonnement solaire

Mais il y a pire… les techniques permettant d’accroître la fraction du rayonnement solaire réfléchie par la Terre afin d’en réduire la température globale nommées modification de l’albédo.

Albedo

L'albédo qui mesure le pouvoir réfléchissant de la surface de la Terre pourrait augmenter (0,3 en moyenne pour la Terre, 0 pour le noir parfait, 0,1 pour la mer, 0,2 pour une forêt, 0,8 pour de la neige fraîche, 1 pour un miroir parfait).

Les constructions humaines ont légèrement diminué l'albédo (les toits d'immeubles et des routes ont un albédo supérieur aux forêts, végétaux), mais la fonte des glaces remplacée par des terres à nu pourrait inverser cette tendance. Attention au raisonnement simpliste qui serait de croire que l'augmentation de l'albédo par exemple en déforestant des forêts (couleur sombre) pour les remplacer par des terres de terre sèche (couleur claire) réduirait le réchauffement climatique car augmenterait l'albédo ! Il y a de nombreux autres facteurs comme la réflectance spectrale dans les différentes longueurs d'onde pour les couverts végétaux, l'évaporation végétale ... qui nous empêche de réaliser ce lien.

L'apparition de nuages au-dessus de surfaces à fort albédo (glace, désert) diminue l'albédo et expliquerait aussi l'accélération de la fonte des glaces au Groenland.

Techniques de géo-ingénierie : Aérosols, soufre ... dans les nuages

Il y a des solutions comme l'introduction artificielle d'aérosols, de soufre et de carbonate de calcium dans la stratosphère (pouvoir réfléchissant accru), le blanchiment des nuages grâce à la pulvérisation d'eau salée (formation de gouttelettes plus petites au pouvoir réfléchissant plus important), la libération des produits chimiques dans la haute troposphère pour réduire la formation de cirrus, l'augmentation de la luminance des nuages et des océans, la restauration artificielle de la banquise en pulvérisant de l'eau de mer à sa surface pendant l'hiver.

On devine que l'impact de ses solutions serait catastrophique pour notre environnement, néanmoins, il y a une très forte pression aux États-Unis, pour financer ces expériences car selon un certain nombre d'entreprises privées et d'ardents défenseurs du " American Way of life ", cela permettrait d'éviter de mettre en place des mesures pour réduire nos émissions de CO2 et de poursuivre notre train de vie actuel ... Hallucinant !

Aujourd'hui, ces solutions sont imaginées comme des solutions de dernier recours ... des sociétés privées militent en disant que nous devons les déployer car nous n'aurions plus aucun recours (certainement des anciens climato-sceptiques qui ont retourné leur veste dans le sens de l'argent !) ...

Malheureusement, sous la pression, des Etats comme les Etats-Unis pourraient justifier envers leur population qu'ils ont le couteau sous la gorge et n'ont d'autre choix que de les utiliser pour préserver le mode de vie américain ... (à très court terme) quel qu'en soit le prix. D'ici 2025, il y a de fortes chances si Donald Trump est réélu que des expérimentations à large échelle soient réalisées au détriment d'ailleurs des pays voisins qui ne pourront pas construire des murs du fond des océans montant jusqu'au ciel !

Il existe des solutions nettement plus simples et moins dangereuses comme peindre des routes, toits et autres infrastructures dans des couleurs réfléchissantes et augmenter la couverture végétale (qui augmente l'humidité de l'air). Los Angeles aurait réduit de 7 degrés la température du sol en peignant ses routes en blanc.

L'installation de panneaux solaires augmenterait la température (albédo plus faible) mais aussi les précipitations ce qui dans ce cas aurait un impact positif au Sahara.

L'imagination des hommes pour imaginer des solutions simples à des problèmes complexes est sans limites d'autant que cela engendre des problèmes encore plus complexes à résoudre... Nous aurions intérêt à accepter que dans la très grande majorité des cas, il n'y ait aucune solution simple et globale et qu'une approche beaucoup plus locale soit bien plus pertinente.

Plus globalement, ce serait un grand pas pour l'humanité de comprendre que la meilleure manière de résoudre un problème est de ne pas le créer. Utiliser la géo-ingénierie (hors reboisement et technologies locales), est un peu comme demander une rallonge à un prêteur sur gage avec un taux usurier pour rembourser ses dettes. Ca finit rarement bien ...

Tech for Gods for everyone - Risques de démocratisation

Auparavant les technologies pouvant avoir un impact majeur sur notre planète étaient réservées à des Etats, créer une bombe nucléaire est difficile à faire au fond de son jardin.

Avec les objets connectés, l'IA, les réseaux sociaux, les données collectées sur chacun de nous sur Internet et nos smartphones, une entreprise devient capable de transformer la destinée d'un pays en manipulant les élections (cf. excellent documentaire sur le scandale de Cambridge Analytica).

Rappelons qu'un grand nombre d'élections se jouent à quelques pour cent près et qu'attiser sur les réseaux sociaux, les conflits latents et désaccords entre communautés, populations est une méthode employée pour inciter les indécis à voter pour certaines extrêmes.

Les véhicules autonomes, les objets mobiles autonomes ... (cf. article sur les armes autonomes) dans les mauvaises mains pourraient un jour transporter et lâcher des charges explosives ou biologiques ...

Allons plus loin, les ciseaux génétiques Crispr Cas 9 (cf. article) est à la portée de n'importe quel laborantin débrouillard. Il est rassurant de voir que He Jiankui, médecin chinois qui a modifié génétiquement des embryons humains d'où sont nées les 2 " bébés Crispr " ait été condamné à 3 ans de prison et à une interdiction d'exercer. Sera-t-on capable d'empêcher tout le monde de le faire ? Pourra-t-on s'assurer que personne ne pourra récupérer un virus de la grippe et le manipuler génétiquement pour en faire une arme biologique mortelle ?

Risques de la démocratisation et moyens pour la contrôler

La démocratisation des technologies est une très bonne chose, l'inconvénient est que dans toute population, il y a quelques % à avoir des comportements " déviants ". L' accès facile à ces technologies est un risque majeur. Aux Etats-Unis, la facilité d'accès aux armes est un contributeur aux tueries en masse aux Etats-Unis et bon nombre des tueurs se doutent qu'ils y laisseront leur peau. Si ces mêmes personnes ont accès à ces nouvelles armes, il est extrêmement difficile de le contrôler.

Nick Bostrom dans une intervention à TED dénomme ce type de technologie une " Black ball ", une technologie facile à mettre en oeuvre capable entre de mauvaises mains de détruire un très grand nombre d'êtres humains rendant notre monde très vulnérable (cf. mes prédictions 2019 sur L'Humanité aux pieds d'argile).

Ses deux préconisations pour y faire face sont un contrôle massif de la population et une gouvernance mondiale car il considère que les deux autres solutions, réduire la vitesse de la technologie et réduire le nombre de personnes y ayant accès est impossible.

Je suis vraiment opposé à cette vision, car vivre dans une société liberticide inciterait beaucoup plus à se rebeller contre elle et à utiliser des solutions à portée de main pour la détruire quitte à se détruire soi-même. Une gouvernance mondiale pour encadrer le développement technologique me semble illusoire à court terme à moins d'avoir des extra-terrestres impérialistes qui nous menacent ou un astéroïde qui frappe la Terre dans les mois qui suivent.

Les espoirs sont faibles que les Etats se coordonnent quand on voit leur implication ténue illustrée par les non-résultats de la COP 25 pour faire face au dérèglement climatique.

La situation géo-politique aggrave encore cette situation car nous assistons à la création de blocs isolationnistes qui s'opposent. Plutôt que de partager une ressource commune, chaque bloc veut se l'accaparer au détriment des autres. La Chine déploie ses routes de la Soie comme des racines pour récupérer les ressources planétaires et alimenter son arbre. C'est la tragédie des biens communs.

Il y a sans doute une autre voie possible que je décris plus loin ...

Tech Bashing

Avant même de parler de tech bashing, la consommation de biens technologiques plafonne et commence même à diminuer y compris dans les pays émergents.

Lassitude vis-à-vis de la technologie

Même si cela reste encore minoritaire et principalement européen, il y a une conscience qui se développe pour réduire sa consommation, on parle de "Green Friday" pour faire face au consumériste "Black Friday".

Le CES Las Vegas, la Mecque des objets électroniques auquel je participe chaque année (pas très écolo tout ça 😉 ), commence à montrer des signes de faiblesse, il y a moins de délégations, moins d'exposants et a priori de visiteurs (en particulier français et chinois). Un indicateur intéressant est la forte réduction des prix en décembre des chambres d'hôtel à Las Vegas durant le salon (grâce à l'annulation gratuite, cela fait gagner quelques centaines d'euros...).

Impacts de la technologie sur notre planète et les inégalités

Notre mode de consommation associé aux technologies a des impacts de plus en plus négatifs sur notre santé en plus du réchauffement climatique. 91% de la population mondiale ne respire pas un air sain selon la Banque mondiale !

Même si l'extrême pauvreté a fortement diminué, la pauvreté n'a pas diminué fortement et les inégalités ont explosé qu'on illustre par la courbe de l'éléphant (dont l'interprétation est un peu tronquée et corrigée par la suite).

Parmi les 10 personnes les plus riches au Monde, 4 sont issus des GAFAM, 3 ont directement bénéficié de la révolution numérique (CEO Zara, Oracle, America Moval, telco mexicain), seul Bernard Arnault, président de LVMH et Mukesh Ambani à la tête d'un conglomérat indien sont à la tête d'industries " traditionnelles ". Warren Buffet est le financier de la bande.

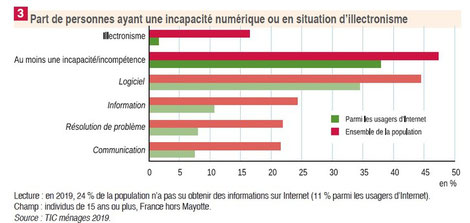

En sens inverse, 15 % des Français n'ont pas utilisé Internet durant l'année, ce chiffre monte à 41 % pour les titulaires d'un Certificat d'études primaires (CEP). Alors que de plus en plus de services deviennent accessibles uniquement par Internet, une part importante de la population ne peut y accéder.

Le numérique, permet d'un côté de rendre accessibles beaucoup de services y compris pour les personnes ayant un handicap (comme les assistants vocaux pour les personnes ayant une déficience visuelle) mais creuse aussi une fracture numérique qui peut susciter méfiance voire opposition à lui.

Fragilité de notre société et notre dépendance

La dépendance de ces technologies, leur accès à l'électricité, aux télécoms peuvent nous rendre méfiants en cas de panne. Que ferons-nous si nous devons arbitrer entre notre consommation personnelle pour nous chauffer ... et la consommation énergétique de ces technologies ?

Aujourd'hui, l'énergie est assez peu chère, mais il y a de fortes chances qu'elle augmente très fortement. Les tensions géopolitiques avec un risque majeur de surenchère, récemment entre les Etats-Unis et l'Iran peuvent toujours être à l'origine d'un conflit régional qui induirait une très forte augmentation du prix du pétrole (l'Iran peut bloquer le détroit d'Ormuz par où passe aujourd'hui un tiers du trafic pétrolier soit 20% de la consommation ). Il s'agit très certainement d'une coïncidence 😉 mais les élections américaines ont lieu cette année ...

Néanmoins, il y a une autre raison pour laquelle, l’énergie devrait augmenter. Il y a un lien direct entre la consommation d’énergie et l’émission de CO2. Pour réduire fortement la consommation d’énergie, il est nécessaire de fortement augmenter ses prix. Les Etats devraient donc augmenter voire fortement augmenter les prix de l’énergie via les taxes (taxe carbone). Le problème est l’impact sur la population, qui pourrait être compensée par des primes, aides … aux plus défavorisés.

Pour l’électricité, elle est en moyenne à 0,2€ par kWh en Europe, 0,176€ en France et 0,3€ en Allemagne ce qui ne l’empêche d’exporter fortement. Une augmentation de la taxe carbone sur le plan européen semble être la seule solution car limitée à un Etat, elle défavoriserait trop son économie aux dépens de ses voisins.

Nous pâtissons aussi de l'effet rebond, en augmentant notre efficacité énergétique, nous incitons à plus consommer.

Perte de contrôle face aux technologies

Les êtres humains vont aussi craindre de perdre le contrôle face aux technologies. Le manque de contrôle humain en dernier ressort aurait conduit au crash du Boeing 737 MAX. Le système MCAS de l'avion est un correctif numérique qui doit compenser le cabrage de l'avion en raison de la nouvelle position des moteurs. Se fondant sur une sonde défaillante, le MCAS a considéré que l'avion se cabrait alors qu'il était en position normale, les efforts répétés des pilotes pour redresser l'avion ont été contrecarrés par le MCAS qui le faisait piquer. Il a fini par prendre le dessus sur les pilotes menant au crash.

Il y a un vrai risque que nous soyons de plus en plus en désaccord et même en conflit avec les décisions prises par des machines et que nous perdions le contrôle dessus.

De plus, il y a un flou juridique concernant la responsabilité d'un accident en particulier mortel, s'il implique l'IA. Est-ce l'exploitant, le prestataire ou le concepteur de l'IA qui est responsable ? La jurisprudence constituera les premiers éléments de réponse avant qu'un cadre juridique clair soit établi.

Données personnelles et perte de confiance dans les entreprises, les institutions.

D'un côté, de grandes marques, même si c'est loin d'être la majorité ont des agissements illicites: CDiscount, Allociné et Vanity Fair collectent nos données même si on refuse , la société Ring, populaire aux Etats-Unis pour ses interphones vidéos donne accès à la police à la localisation de ses produits afin qu'ils puissent solliciter les propriétaires à transmettre leurs vidéos.

Le nombre de fuites de données personnelles s'est fortement accru et les pannes aussi (cf. une augmentation de crashs des applications chez Facebook.)

Les citoyens et consommateurs deviennent de plus en plus méfiants des entreprises et des données qu'ils récupèrent sur nous. Facebook doit payer une amende 5 md$ aux Etats-Unis pour avoir violé les droits à la vie privée, ce qui au passage est une nouvelle façon de faire payer des "impôts" aux GAFA ! L'application chinoise TikTok utilisée déjà par 26 M d'Américains pour partager des vidéos est suspectée d'avoir des failles permettant à la Chine de collecter les données. L'application russe FaceApp rajeunissant, vieillissant votre visage ou le changeant de genre, collecte et transmet vos données en Russie..

Le développement de la reconnaissance faciale commence à effrayer les citoyens compte tenu de son usage en Chine pour noter chacun. A ce titre, la CNIL fait un réel travail d'analyse à ce sujet pour que son utilisation soit proportionnée au service rendu.

La Commission européenne en voulant protéger les citoyens avec la nouvelle réglementation e-privacy, risque de renforcer le pouvoir des GAFA car elle favorise les "first party cookies" et les sites web où on se logge (ex : avec le Login Facebook ou Google).

Pour des raisons différentes, les citoyens ont aussi de moins en moins confiance en leurs Etats en raison des différents scandales politiques, de l'inégalité de traitement entre les citoyens les plus riches et les autres ...

La propagation de fake news ne facilite pas les débats constructifs. Rappelons que selon une étude Ifop, près d'un Français sur 10 croit que la Terre est plate ! L'avantage des fake news sur la vérité est que si elles sont bien choisies, elles ne contredisent jamais vos idées ce qui est nettement plus confortable. Toute idée contraire aurait pour objectif de vous faire douter de cette " vérité imaginaire et fausse".

Au final, il y a un vrai risque de perte de confiance des citoyens à juste titre dans de nombreux cas mais aussi à tort car les données permettent aussi de résoudre bien des problèmes (médicaux, environnementaux ...) si elles sont bien utilisées comme l'explique très bien Aurélie Jean dans le Petit Quotidien à la suite de la publication de son livre sure les algorithmes.

Peur de la perte d'emploi

Il est aussi probable que des entreprises comme les banques, les assurances soient confrontées à des dilemmes, tels que réduire fortement leur nombre d'employés grâce à l'automatisation permise par l'IA ou les maintenir dans l'emploi en assurant des formations.

Si de grands plans de licenciement suivent l'utilisation massive d'IA et la forte augmentation des profits, il ne serait guère étonnant que le grand public associe massivement IA et perte d'emplois, y soit vent debout et risque d'accroître le sentiment d'inégalités entre ceux qui sont dedans et ceux qui sont dehors ou vont bientôt l'être.

Plutôt que le revenu universel inconditionnel pour compenser la perte d'activité, je suis favorable à ce que les salariés sujets à un licenciement économique puissent bénéficier sur une période de 1 an à 3 ans à une part des bénéfices additionnels générés après leur départ. Cela permettrait de redistribuer une partie des gains de productivité apportés par l'IA, les robots.

Notre monde évoluant beaucoup plus rapidement qu'avant en termes de technologies et d'emploi, un très grand nombre de personnes développent une très forte appréhension à entrer dans l'inconnu.

Technologie plus humaine, locale, durable, proportionnée au problème

Nous pensions accéder à des ressources illimitées alors nous utilisons la technologie à tout bout de champ pour résoudre tout nouveau problème sans toujours vérifier s'il existe déjà des solutions pertinentes moins consommatrices en énergie, avec moins d'impacts négatifs sur notre environnement ...

Pédagogie - Bien définir les problèmes à résoudre et les solutions correspondantes

Une manière simple de réduire fortement la mise en place de technologies inutiles est de bien poser le problème et d'identifier les solutions pertinentes.

Cela paraît du bon sens mais très souvent on prend le chemin inverse. Par exemple, on va mettre en place un programme d'IA et on va chercher des problèmes qui pourront être résolus avec. Dans la majorité des cas, c'est complètement inefficace et cela crée des usines à gaz. Comme le dit le proverbe quand on est un marteau, tout ressemble à un clou.

La pédagogie est aussi essentielle. J'avais réalisé avec Cédric Villani une conférence publique à Saint-Christoly-de-Blaye près de Bordeaux sur l'intelligence artificielle et la ruralité, deux sujets qui a priori s'opposent. La salle était pleine à craquer, Cédric et moi avions préparé des cas pratiques (cf. pièce jointe) pour montrer comment dans l'agriculture, la mobilité, l'IA pouvait aider. Après avoir démythifié ce qu'est l'IA, et présenté des cas d'usages dans la ruralité, les questions ont fusé. Une des participantes est même venue me voir à la fin me disant : "J'ai enfin compris ce qu'est l'intelligence artificielle et en quoi elle me concerne." Nous avons réussi à créer un lien entre deux mondes qui ne se parlaient pas et à rendre accessible ce qui ne le paraissait pas.

Créer des ponts, expliquer ce qu'apporte les technologies avec les plus et les moins, donner des exemples concrets permettent d'éviter les rejets massifs et sans discernement.

« Impact Crowns » - Couronne d'impact sur le plan sociétal, environnemental et économique

Une manière de représenter la valeur d’une technologie et plus globalement d’ un service, d’un produit mais aussi d’un projet est de le subdiviser en 3 impacts : impact sociétal, environnemental et économique.

Les impacts potentiels seraient mesurés de manière positive et négative de manière distincte sur une échelle de -3 à 3.

On peut utiliser cette visualisation pour de gros projets comme pour des initiatives personnelles.

Pour donner un exemple, l'installation d'éoliennes en Allemagne a un impact positif sur le plan environnemental car cela compense l'utilisation de centrales à charbon pour produire de l'énergie mais aussi un impact négatif.

Il faut construire ces éoliennes consommatrices de ressources et cela peut avoir un impact sur la biodiversité locale en particulier les oiseaux. Sur le plan sociétal, l'impact positif est potentiellement de créer quelques emplois, l'impact négatif sont les nuisances visuelles et sonores. Sur le plan économique, l'impact positif est de donner accès à une énergie peu chère.

Sur le plan individuel, un voyage aux Maldives en venant de France aurait sur le plan humain, un impact positif (c'est les vacances !), sur le plan environnemental très négatif (voyage en avion et impact touristique sur les îles), sur le plan économique positif (si contribue au développement économique de l'île) et négatif (car réduit le budget des touristes).

Petite digression, il semble compliqué d'interdire de voyager aux Maldives mais on peut d'une part réduire sa fréquence (en plus de la taxe carbone, on pourrait imaginer des visas / autorisations (comme l'ESTA US qui coûte 14 USD) mais écologiques avec des prix différenciés en fonction de la distance entre le point de départ et la destination... C'est une idée à proposer au gouvernement car la France est le 1er pays touristique du monde...

Certains choix, comme ceux de la Norvège de renoncer à 65 milliards de dollars en annulant ses projets de forage dans les îles Lofoten pourraient être réalisés sur cette base. En revanche, ils ont inauguré Johan Sverdrup, une méga-plateforme pétrolière près de leurs côtes …

Pour chaque axe, il faudrait avoir un indice synthétique qui mesure de manière représentative la situation actuelle et la situation future. Le choix des indices est évidemment crucial et doit se faire avec l’ensemble des acteurs concernés. La taille des échelles est aussi essentielle pour ne pas écraser ou exagérer certains impacts.

Impact économique

L'impact économique est le plus facile a priori car on pourrait utiliser la valeur marchande ou le PIB additionnel apporté par le projet. La valeur non marchande, le bénéfice social serait lui intégré dans l'impact sociétal. Néanmoins, je propose une petite subtilité, au lieu de calculer l'impact économique en valeur absolue, nous pourrions utiliser l'impact "moyen" incrémental sur la population concernée.

Pour éviter la concentration de valeur sur quelques individus (qui augmenterait la valeur moyenne arithmétique de manière artificielle), nous pourrions utiliser la moyenne géométrique (qui n'augmenterait sensiblement que si l'impact économique augmente pour l'ensemble des individus.) et comparer la moyenne géométrique avant et après le projet rapportée à la moyenne actuelle.

Si les revenus moyens géométriques passent de 10 à 11, la valeur incrémentale sera de 10% (11-10)/10.

Ici, par exemple l'évolution des revenus depuis 1996 en France selon la moyenne arithmétique, médiane et la moyenne géométrique et l'écart entre les 10% plus riches et plus pauvres. L'inconvénient de ce rapport est que si vous améliorez fortement le niveau de vie des très pauvres sans aider les classes pauvres et moyennes, cet indice d'inégalité se réduit or ce n'est pas représentatif de la courbe complète. La courbe en éléphant illustre bien ce problème.

Impact environnemental : Mesurer de manière positive et non en termes de réduction

Un gros problème actuel est la mesure des effets bénéfiques que nous pourrions avoir sur l'environnement et sur notre société.

A la différence de l'impact économique qui se mesure en augmentation du PIB, l'impact environnemental se mesure de manière négative en réduction d'émissions en équivalent de CO2, ce qui n'est pas très encourageant ! Il est toujours plus motivant d'avoir des chiffres qui augmentent que des chiffres qui baissent ...